Успехам в хватании предметов мы обязаны, в частности, зрению. Вещь можно подобрать и не видя ее, но если следить за движением рук, то получается лучше. У роботов есть аналог зрения, обеспечивающий визуальное самоуправление, которое не только повышает точность движений, но и позволяет брать предметы, которые движутся вокруг вас и меняют направление в тот момент, когда вы их хватаете.

Более изобретательный способ — это позволить роботам учиться самостоятельно. Команда ученых Google Research при помощи коллег из X, поставила задачу роботу 7-DoF подбирать предметы в лотке, используя монокулярное визуальное самоуправление и сверточную нейронную сеть (CNN) для предугадывания последствий хвата.

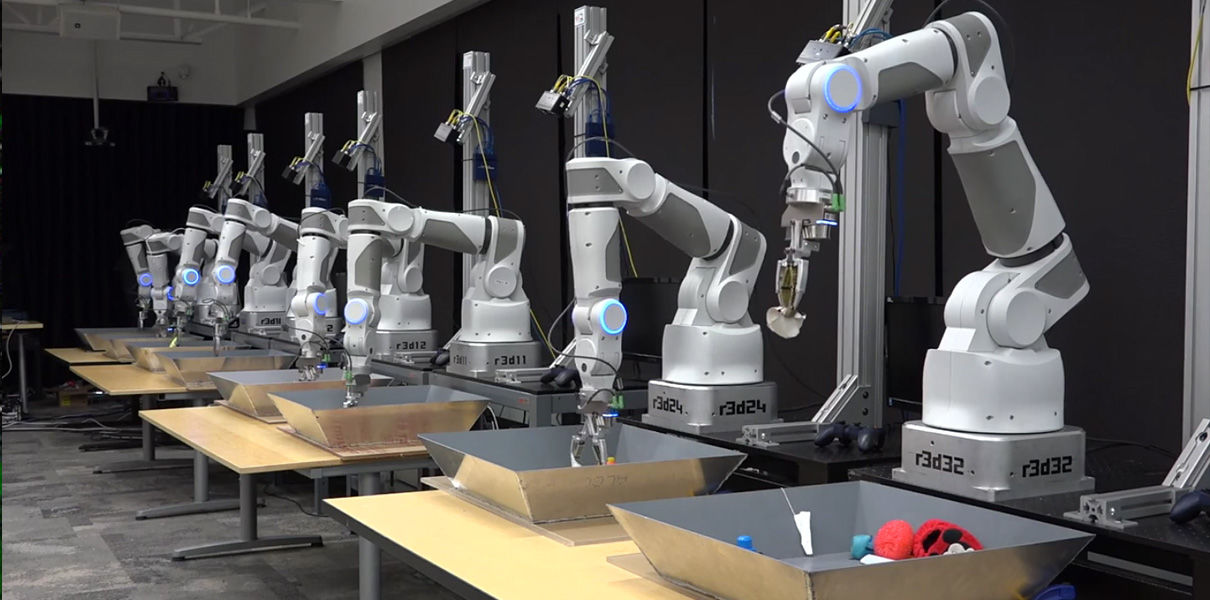

CNN постоянно обучается (поначалу ошибок много, потом их становится меньше), а чтобы ускорить процесс, Google поставила рядом еще 14 роботов. Все они полностью автономны: людям нужно было лишь наполнить лотки предметами и включить питание.

Выполняя задание, робот постоянно предсказывает, наблюдая за действием своей руки, какое следующее действие максимально увеличит эффективность. В результате получается своего рода координация движений между глазом и рукой.

Наблюдая за примерно 800 000 попытками (около 3000 робото-часов практики), ученые сделали вывод, что у них начинает формироваться реактивное поведение. Роботы оценивают движения своего манипулятора и корректируют его действия в реальном времени.

Также роботы стали проявлять интересные особенности поведения. Например, они отделяли один предмет от других, чтобы легче было его взять. Все эти действия возникли спонтанно, в процессе обучения, а не были запрограммированы.