Подразделение DeepMind от Google продолжает исследовать новые возможности искусственного интеллекта и машинного обучения. После победы алгоритма AlphaGo над действующим чемпионом по го, нейросеть занялась освоением тактики футбола. С нуля программа учится двигаться по полю, вести мяч и даже забивать голы, сообщает Engadget.

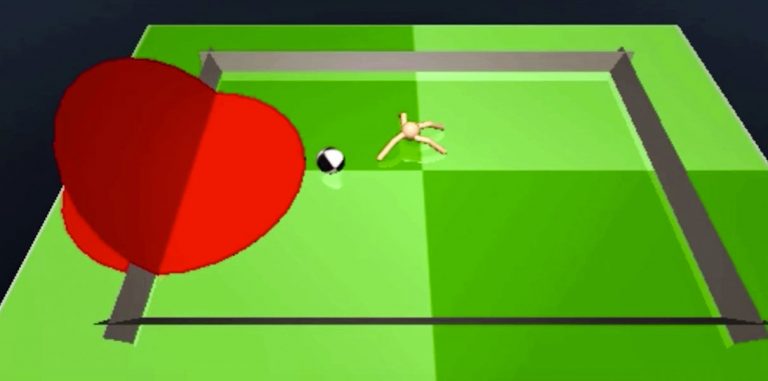

Для ведения игры алгоритм управляет цифровым изображением паука. На первый взгляд весь процесс кажется игрушечным и даже смешным, но за ним стоит сложная ИИ-система.

Искусственный интеллект использует асинхронное обучение с подкреплением, то есть самостоятельно учится выполнять различные действия, полагаясь на метод проб и ошибок.

Как отмечает в блоге ведущий программист DeepMind Дэвид Сильвер, такой подход в сочетании с иерархической системой контроля позволяет решать комплексные задачи. Например, играть в футбол или заниматься слаломом без какого-либо изначального представления о динамике и механике этих видов спорта.

В данном случае ИИ самостоятельно пытается понять, как двигать паука по полю и как забивать голы.

DeepMind также сообщила о выпуске системы подкрепленного обучения Gorila. Она базируется на платформе Google Cloud и позволяет ускорить процесс обучения алгоритмов с помощью порядка величины. Система уже используется в рекомендательных сервисах Google.

Также в ближайшие месяцы подразделение выложит в открытый доступ программу Labyrinth, с помощью которой можно научить нейросети находить выход в виртуальных лабиринтах.