Джейсон Ташеа, основатель консалтинговой компании в сфере уголовного судопроизводства и технологий Justice Codes, написал колонку для Wired, в которой призвал запретить использование искусственного интеллекта для вынесения приговоров в американских судах.

«Алгоритмы все больше проникают в нашу жизнь, начиная музыкальными рекомендациями и кредитными рейтингами и заканчивая судебными решениями о временном освобождении до проведения слушаний и вынесением приговоров. Но в том, как они работают, отсутствует прозрачность и какой-либо контроль, — пишет Ташеа. — Нигде эта нехватка контроля не может быть более критичной, чем в системе уголовного правосудия. Без надлежащих гарантий безопасности эти инструменты подрывают верховенство права и ущемляют права людей».

По словам Ташеа, многие американские суды и исправительные учреждения сейчас используют машинные алгоритмы для определения уровня различных рисков, начиная от вероятности того, что обвиняемый совершит еще одно преступление и заканчивая риском того, что он не придет в суд на рассмотрение своего дела (после временного освобождения под обязательство явиться в суд). Судьи используют алгоритмы для принятия решений об освобождении под залог, назначении наказания и досрочном освобождении.

Создан концепт небоскреба с напечатанными квартирами-модулями

Идеи

Тем не менее, государственные органы обычно не пишут собственные алгоритмы — они покупают их у частных компаний, и это зачастую означает, что только владельцы ПО и, в некоторой степени, его покупатели могут знать о том, как алгоритм принимает решение. На текущий момент не существует федерального закона или каких-либо других стандартов, которые требуют проводить проверку этих алгоритмов, как, например, происходит в случае с одобрением новых лекарств Управлением по санитарному надзору за качеством пищевых продуктов и медикаментов США.

Такая непрозрачность судебных ИИ-систем уже имеет реальные последствия. В деле Висконсин против Лумиса обвиняемый Эрик Лумис был признан виновным в совершении выстрелов из окна своей машины. Во время допроса Лумис ответил на ряд вопросов, и его ответы были введены в Compas, программу для оценки рисков, разработанную частной компанией и используемую Департаментом исправительных учреждений штата Висконсин.

Американский суд постановил, что биткоины — это не деньги

Технологии

Compas оценил «риски» Лумиса как высокие, и в результате судья назначил ему максимально возможное наказание. Лумис попытался оспорить приговор на том основании, что у него не было возможности оценить механизм принятия решений алгоритмом. Верховный суд штата вынес решение против Лумиса, постановив, что знание итогового решения алгоритма уже подразумевает достаточный уровень прозрачности.

По мнению автора колонки, уголовное правосудие и правовые сообщества могут пойти двумя путями: либо слепо разрешить верховенство технологии, либо ввести мораторий на использование непрозрачных ИИ-алгоритмов для оценки рисков в уголовном судопроизводстве до тех пор, пока не будут разработаны единые процедуры для определения их качества.

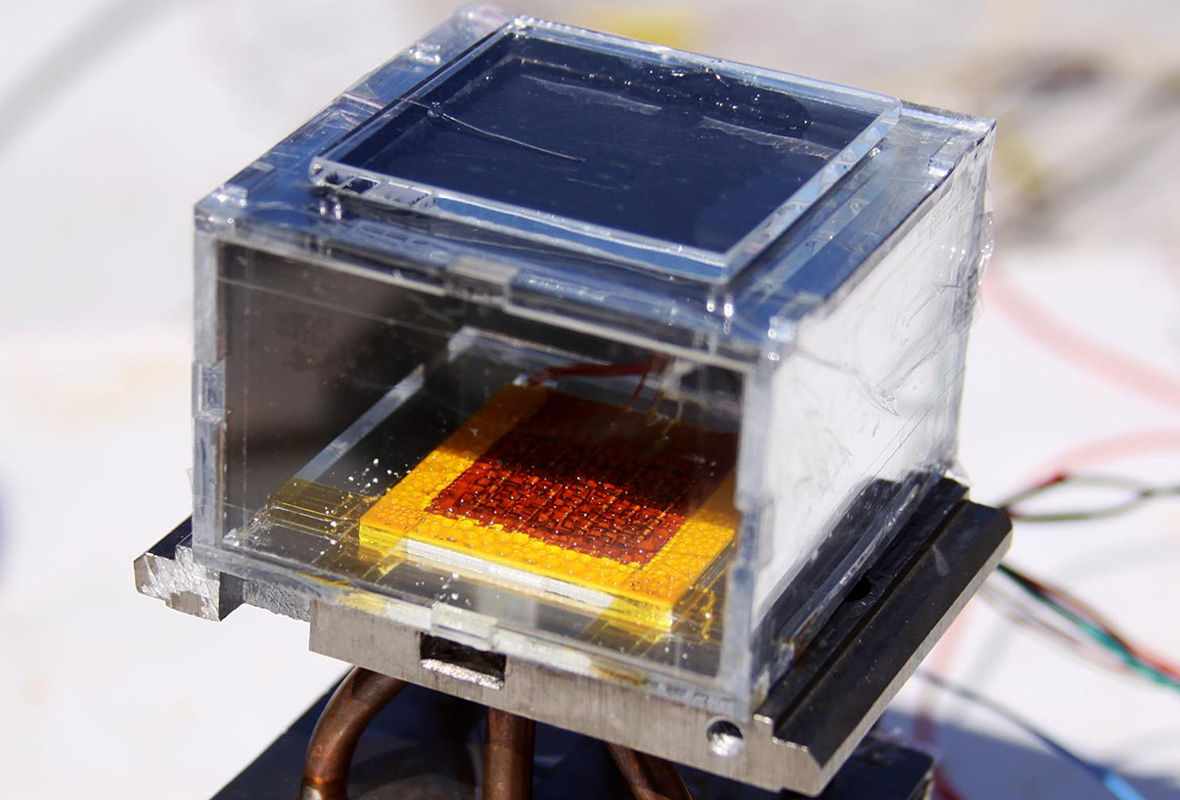

Физики создали прибор, извлекающий воду из сухого воздуха

Идеи

По данным The Wall Street Journal, суды, как минимум, пятнадцати американских штатов уже используют машинные алгоритмы для вынесения решений о досрочном освобождении заключенных. По мнению разработчиков таких алгоритмов, искусственый интеллект помогает исключить нежелательное влияние человеческого фактора на принятие решений.