Предвзятость ИИ-судей стала одним из самых обсуждаемых вопросов в 2017 году. Но, как показывают исследования, иногда искусственный интеллект оказывается более рассудительным и справедливым, чем человек. New York Times объясняет, почему судебная система выигрывает от применения ИИ.

Стоит ли отпускать подсудимого под залог или можно обойтись без залога — такой выбор регулярно приходится делать американским судьям. Обычно решение выносится стремительно, а на его обдумывание не остается времени. Судьям приходится полагаться на интуицию и личные предпочтения. В результате чаще всего подсудимых отпускают под залог.

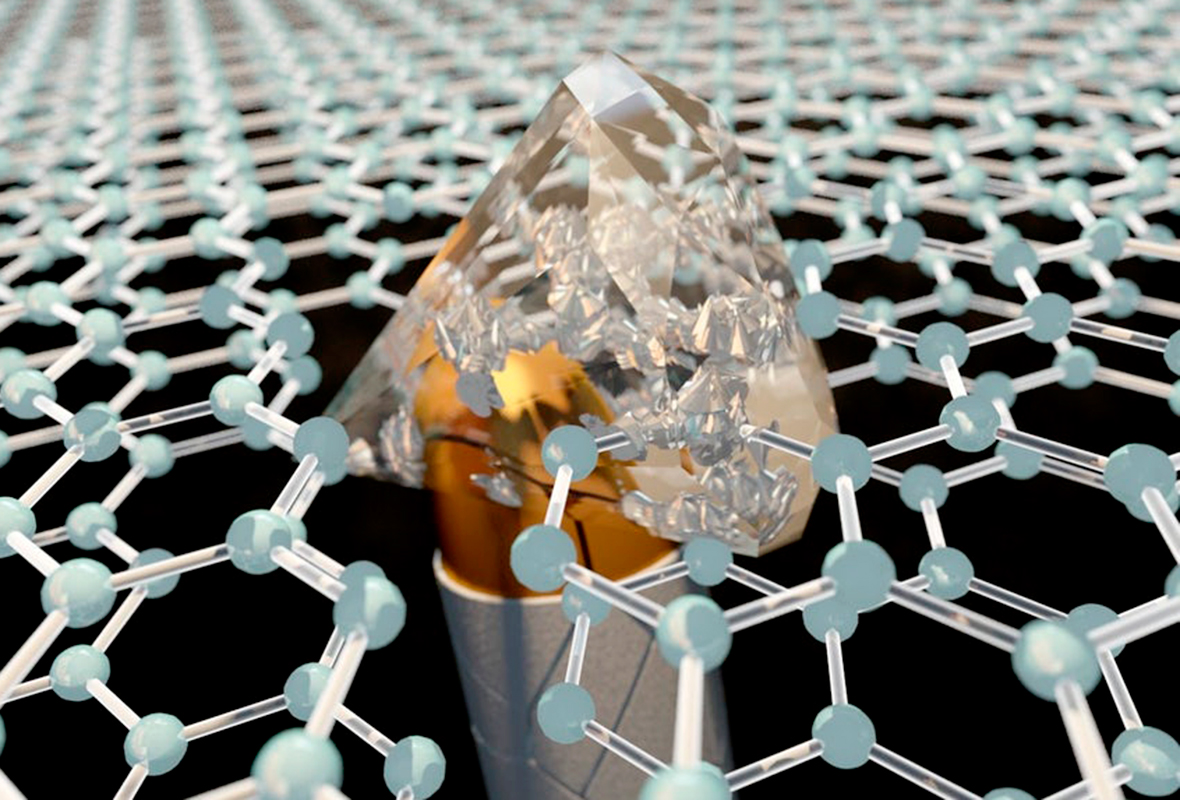

Ровно два слоя графена смогут остановить пулю

Идеи

Чтобы сделать решения более взвешенными, некоторые суды в США начали использовать алгоритмы. Программы просчитывают все возможные риски и определяют, можно ли отпустить подозреваемого до суда и на каких условиях это лучше сделать. Эксперимент в штате Вирджиния показал, что ИИ в два раза чаще отпускал подсудимых. Но при этом количество преступлений, совершаемых подозреваемыми в ожидании суда, не увеличилось.

Аналогичный эксперимент провели в Нью-Джерси. В результате количество заключенных, ожидающих суда, сократилось на 16%. На уровне преступности это никак не сказалось.

Успешные опыты работы с алгоритмами проводились и ранее. Еще в 2008 году в Филадельфии компьютерная программа помогала решать, каких преступников стоит выпускать условно-досрочно. В итоге полиция тратила меньше времени на контроль за освобожденными с низкой степенью риска, а уровень преступности при этом не вырос. Более того, судебная система получила выгоду от содержания меньшего количества заключенных, так как это помогло сократить расходы.

«На Западе прекратят пить алкоголь и перейдут на безвредный алкосинт»

Мнения

По мнению авторов NYT, эти примеры доказывают, что грамотно использованные данные и статистика помогают выносить более справедливые решения, в которых нет непоследовательности и скрытой предвзятости.

Однако это зависит от качества алгоритмов. Некоторые системы несовершенны и переносят на себе предубеждения разработчиков. Причиной служат неверные расчеты и статистика. Но большинство разработок, уверены авторы, не должны вызывать подозрений.

В 2016 году организация ProPublica проанализировала 7000 судебных случаев и обнаружила, что темнокожим правонарушителям алгоритмы чаще присуждают средний и высокий показатель риска рецидивизма. Аналитики пришли к выводу, что в программе укоренены расистские предрассудки. Но некоторые эксперты отмечают, что алгоритм не может действовать предвзято — он учитывают только статистические факторы, и раса не становится для ИИ отягчающим фактором.

«В силу социальных и экономических причин темнокожие заключенные в данном регионе действительно чаще совершают преступления после освобождения», — пишут авторы. Они приходят к выводу, что в решении алгоритма виноваты не предубеждения, а социальное неравенство. Поэтому, на первый взгляд, такая программа может показаться предвзятой и несовершенной, но по факту механизм ее работы вполне логичен.

США: «Космос — это не всеобщее достояние»

Мнения

Ошибочными могут быть не только прогнозы алгоритмов, но даже тесты ДНК, взятые с места преступления. В сентябре Общество правовой помощи Нью-Йорка обратило внимание на то, что многие методы анализа ДНК, применяемые при расследованиях, далеки от совершенства и могут давать ложные результаты.