Самое страшное в искусственном интеллекте — его закрытость и фактическая необъяснимость процессов, которые происходят внутри этого «черного ящика» в процессе принятия решений. Этим могут воспользоваться злоумышленники. Киберпреступники могут обмануть ИИ с помощью вредоносного ПО для достижения самых разных последствий: от политических провокаций до настоящих катастроф. «Хайтек» перевел статью Gizmodo об опасностях непредсказуемости ИИ, современного регламента и попытках контролировать процессы принятия нейросетями решений, а также о существующих способах обмана ИИ.

За последние два года мы узнали, что алгоритмы машинного обучения могут манипулировать общественным мнением, стать причиной ДТП со смертельным исходом, создавать поддельные порноролики и демонстрировать чрезвычайно сексистское и расистское поведение.

А теперь мы совершенно точно видим в ИИ потенциальную угрозу мировой кибербезопасности. Только сейчас для нас становится очевидным будущее, в котором киберпреступники обманывают нейронные сети, принуждая их к совершению фатальных ошибок, и используют глубинное обучение, чтобы скрыть вредоносное ПО и добраться до миллионов пользователей ПК.

Проблема защиты ИИ заключается в том, что трудно объяснить, как они на самом деле работают. Даже людям, которые их создают, не так-то просто объяснить эти механизмы «на пальцах». Но если мы не подготовимся к тому, что может произойти, мы никогда не научимся оценивать подобные сценарии и грамотно реагировать на эти угрозы.

Под прицелом у ИИ

В 2010 году США и Израиль, по мнению многих исследователей, совместно выпустили Stuxnet — вредоносное ПО, направленное на то, чтобы вывести из строя всю ядерную инфраструктуру Ирана. Stuxnet распространяется как сетевой червь, но может навредить, только если окажется внутри сетевой конфигурации, идентичной конфигурации ядерной установки Ирана в Натанзе. Червь Stuxnet по-прежнему является одним из самых сложных вирусов, когда-либо созданных, и его целенаправленная атака стала возможной лишь благодаря информации и ресурсам, доступным спецслужбам.

Сетевой червь — разновидность вредоносной программы, самостоятельно распространяющейся через локальные и глобальные (интернет) компьютерные сети.

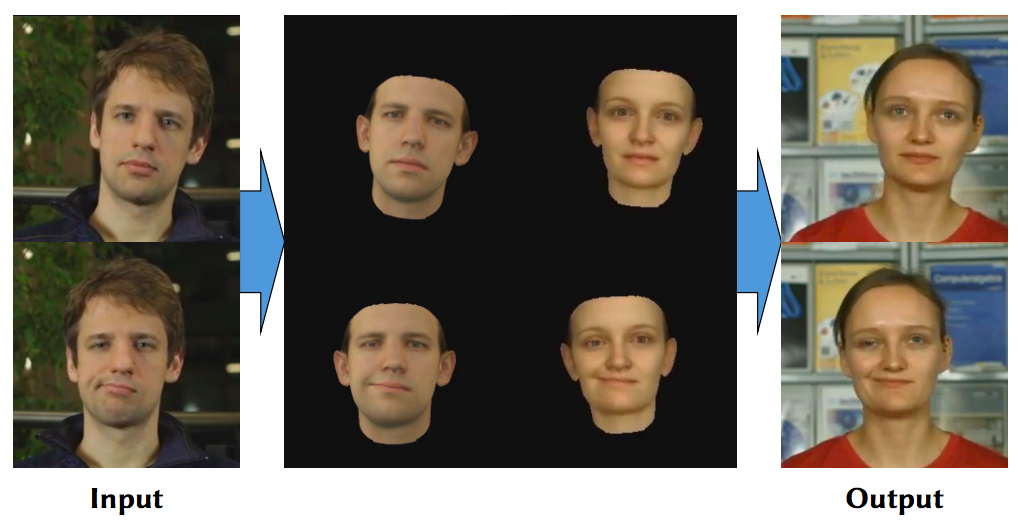

Но в эпоху ИИ создание целевого вредоносного ПО может стать таким же простым, как обучение нейронной сети распознаванию лиц или голосов из предоставленной базы. В августе исследователи IBM представили DeepLocker, доказательство концепции вредоносного ПО, которое использовало глубокие нейронные сети, чтобы скрыть свою настоящую сущность, вариацию атаки хакеров-вымогателей WansCry, и активировалось только при обнаружении цели.

WannaCry — вредоносная программа, сетевой червь и программа-вымогатель денежных средств, поражающая только компьютеры под управлением операционной системы Microsoft Windows. После заражения компьютера программный код червя шифрует почти все хранящиеся на компьютере файлы и предлагает заплатить денежный выкуп в криптовалюте за их расшифровку. В случае неуплаты выкупа в течение семи дней с момента заражения возможность расшифровки файлов теряется навсегда.

Они встроили DeepLocker в приложение с безобидными программами для видеоконференций. В гипотетическом сценарии приложение может быть установлено и использовано миллионами пользователей без проявления какого-либо вредоносного поведения. Между тем вредоносная программа использует нейронную сеть распознавания лиц, настроенную на изображение намеченного целевого объекта или для сканирования видеоролика с веб-камеры компьютера.

Как только лицо цели появляется перед камерой компьютера, на котором запущено зараженное приложение, DeepLocker активируется, зашифровывая все файлы на компьютере жертвы.

«Хотя сценарий распознавания лиц является одним из примеров того, как вредоносное ПО может использовать ИИ для идентификации цели, другие идентификаторы, такие как распознавание голоса или геолокация, также могут использоваться вредоносным ПО, основанным на ИИ, чтобы найти свою жертву», — рассказывает Марк Штоклин, ведущий исследователь проекта IBM, после публикации результатов исследований.

Одну и ту же модель вируса можно использовать и для других целей, например, вредить или шпионить за людьми определенного пола или расы.

Угрожающий аспект вредоносного ПО, работающего под управлением ИИ, такой как DeepLocker, заключается в том, что он использует глубинное обучение как карнавальную маску — лишь чтобы скрыть свою вредоносную полезную нагрузку. Исследователи безопасности обычно обнаруживают и документируют вредоносное ПО путем его обратной инженерии, активируя их в условиях песочницы и извлекая для себя их цифровые и поведенческие подписи. К сожалению, нейронные сети чрезвычайно сложны для перепроектирования, что облегчает обход средств безопасности и аналитиков для злоумышленников.

Обернуть ИИ против самого себя

Еще одной растущей тенденцией угроз на основе ИИ являются состязательные атаки, когда вирусы манипулируют входящими данными, чтобы заставить нейронные сети принимать абсолютно рандомные решения. Уже опубликованы несколько отчетов и исследований, в которых наглядно показано, как эти атаки могут работать в разных сценариях.

Большая часть работы, выполненной в этой области, сосредоточена на использовании алгоритмов компьютерного зрения — отрасли ИИ, которая позволяет компьютерам классифицировать и обнаруживать объекты в изображениях и видео. Это технология, используемая для беспилотных автомобилей, распознавания лиц и приложений для смарт-камер, таких как Google Lens.

Но проблема в том, что мы точно не знаем, как нейронные сети, которые управляют алгоритмами компьютерного зрения, определяют характеристики каждого объекта, и именно поэтому они могут потерпеть крах в совершенно неожиданных ситуациях.

Это еще относительно безвредные примеры. Нейронные сети попадают во все большее число критических параметров. Например, совместные исследования Мичиганского университета, Вашингтонского университета и Калифорнийского университета в Беркли обнаружили, что маленькие черно-белые наклейки на знаках остановки могут сделать их необнаружимыми для алгоритмов ИИ, которые используют беспилотные автомобили.

Человеческое зрение несовершенно, оно часто нас обманывает. Но ни в одном из этих случаев человек не допустил бы такой же ошибки, как ИИ. Все эти исследования подчеркивают один очень важный факт: хотя алгоритмы компьютерного зрения часто выполняют задания на том же уровне или лучше, чем люди при обнаружении объектов, их функциональность существенно отличается от человеческого зрения, и мы не можем предсказать их возможные неудачи, пока они действительно не произойдут.

Из-за непрозрачности нейронных сетей чрезвычайно сложно исследовать их слабые места, и если злоумышленники сначала нащупывают их, либо случайно, либо методом проб и ошибок, им будет легче скрывать и использовать их, чтобы заставить приложения ИИ допускать максимально критические ошибки. Это намеренное манипулирование алгоритмами ИИ известно, как состязательные атаки.

Эти адресные атаки не ограничиваются алгоритмами компьютерного зрения. Например, исследователи обнаружили, что хакеры могут управлять аудиофайлами таким образом, чтобы они не были слышны для человеческого уха, но могли отправлять команды на устройство с поддержкой голосовой связи, например, на интеллектуальный динамик.

Открыть черный ящик

Кибератаки ИИ еще не стали способом заработка. Разработка вредоносных программ и состязательных атак все еще очень сложна, и они не работают единообразно. Но это только вопрос времени и развития массово доступных инструментов. Даже FakeApp, приложение для упрощенной замены лица с использованием глубинного изучения, вызвало волну поддельных порновидео и растущих опасений по поводу угроз использования ИИ для подлога и мошенничества.

Существует несколько предложенных мер защиты от противников. Но даже исследователи признают, что ни одно из решений не является окончательным, потому что они в основном пытаются обратиться к черному ящику нейронной сети, рассматривая его под разными углами, чтобы предотвратить любую возможную неприятную неожиданность со стороны злоумышленников.

Между тем, вредоносное ПО на базе ИИ еще не имеет документального решения. По мнению исследователей, которые впервые подняли эту проблему на поверхность, нет никаких достоверных доказательств того, есть ли в настоящее время вредоносное ПО с ИИ или нет.

Очень важным компонентом безопасности ИИ является его объяснимость и прозрачность. Это означает, что нейронные сети должны либо иметь возможность мотивировать все решения, которые они принимают, либо позволять исследователям перепроектировать и повторять эти шаги.

Создание объясняемого ИИ без ущерба для производительности нейронных сетей сложно, но работа по усовершенствованию уже запущена. Ярким примером является финансируемый правительством США проект под руководством DARPA, исследовательского подразделения Министерства обороны.

Регламент, такой как GDPR в Европейском Союзе и CCPA в Калифорнии, требует, чтобы технологические компании были прозрачны в отношении своих методов сбора и обработки данных и могли давать расшифровку автоматизированных решений, принятых машинами. Соблюдение этих правил также должно очень помочь в достижении объясняемого ИИ. И если технологические компании обеспокоены тем, что они потеряют конкурентное преимущество, сделав внутреннюю работу своих проприетарных алгоритмов понятными, они должны подумать, что ничто не будет более разрушительным для их репутации и в конечном счете приведет к окончательному краху, чем катастрофа в сфере безопасности, связанная с их алгоритмами ИИ.