На YouTube приходится 37% всего глобального мобильного трафика, 70% просмотров видео — на рекомендации. ИИ сервиса отвечает за четверть всего мобильного трафика в интернете — однако в рекомендациях очень часто встречаются видео, помогающие конспирологам продвигать свои теории. Например, 100% участников съезда адептов теории плоской Земли признались, что впервые узнали о ней после просмотра YouTube. «Хайтек» рассказывает, как работает рекомендательный алгоритм сервиса, и как его руководство пытается справиться с распространением теорий заговора (спойлер: безуспешно).

Системы рекомендаций — одна из самых распространенных форм искусственного интеллекта, с которой сталкиваются пользователи, независимо от того, знают они об этом или нет. Такие системы встроены в Facebook и Twitter — и, конечно, в «рекомендуемые видео» на YouTube.

Подобные системы крайне сложны — особенно если речь идет о сервисах, которые посещают десятки миллионов пользователей в день. Как и другие аналогичные нейросети, ИИ от YouTube пытается показать пользователю максимально релевантные видео на основе предыдущих просмотренных им роликов или данных о его интересах, собранных при использовании Google.

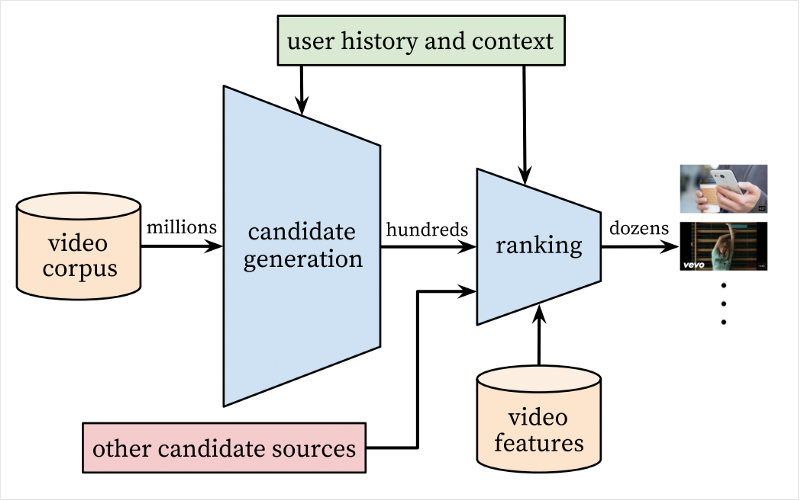

В случае с YouTube ИИ состоит из двух нейросетей — первая генерирует рекомендации, а вторая ранжирует их для конкретного пользователя.

Первичный отбор роликов-кандидатов на попадание в «Рекомендации» происходит на основе анализа активности пользователя. Речь идет о видео, которые он смотрел до этого или сайтах, которые посещал. На этом этапе нейросеть-генератор предлагает несколько сотен вариантов, которые затем актуализирует для конкретного человека. Нейросеть готова отказаться от многих параметров (возраст, пол, местоположение) ради того, чтобы показать пользователю то, что он недавно смотрел.

Затем в дело вступает вторая нейросеть, которая отвечает за ранжирование. Она оценивает ролики-кандидаты по широкому набору критериев и главной задачей видит максимально высокое соответствие видео интересам пользователя.

Для системы рекомендаций не имеет большого значения то, что пользователь пропустит некоторые предложенные ролики — ведь в целом она учитывает самые важные для него маркеры. И на их основе показывает видео, которые быстро набирают просмотры.

Система обучается непрерывно — одной сети дается история активности пользователя до некоторого времени (t), а вторая сеть спрашивает, что пользователь хотел бы посмотреть в момент времени (t + 1). В результате они получают все больше данных и узнают пользователя все лучше и лучше. Разработчики ИИ для YouTube считают, что это был один из лучших способов рекомендовать видео.

Почему YouTube показывает нам конспирологические видео

У рекомендательной системы YouTube при всех ее преимуществах с технической точки зрения есть явный этический недостаток — ее основная цель состоит в том, чтобы пользователь как можно дольше смотрел видео и, как следствие, увидел больше рекламы.

Врезка

Например, алгоритм видит, что клип известного музыканта быстро набирает просмотры и становится вирусным. Нейросеть начинает предлагать его пользователям, которым он может понравится,а автоматическое воспроизведение видео запускает бесконечную череду рекомендаций. И вот пользователь уже смотрит не музыкальный клип, а ролик о том, что американцы не высаживались на Луну или о масонском заговоре.

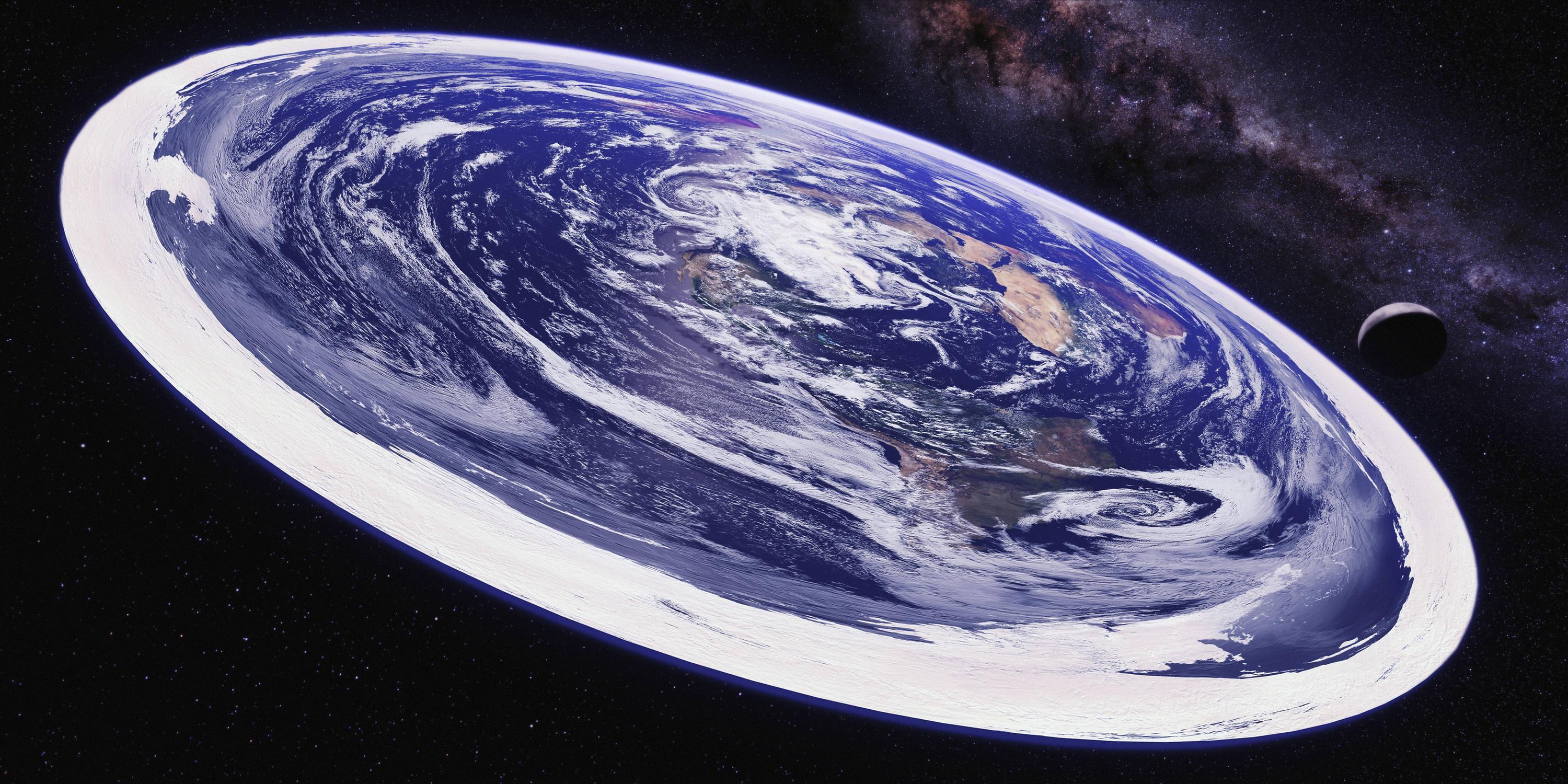

Работу этой схемы хорошо демонстрируют результаты опроса, проведенного на съезде сторонников теории плоской Земли. 29 из 30 участников заявили, что узнали о теории из видео на YouTube.

Теория плоской Земли основывается на идее, предложенной в XIX веке английским изобретателем Сэмюэл Роуботэм. Ее сторонники придерживаются мнения, что Земля является плоским диском диаметром 40 тыс. км, с центром в районе Северного полюса. По всей окружности диска располагается стена льда, которая не дает мировому океану растечься. Теория гласит, что Солнце, Луна и другие звезды вращаются над поверхностью Земли, а все сделанные в космосе фотографии — подделка.

Единственного респондента, который стал сторонником теории плоской Земли до просмотра видео на YouTube, поверил в идею после разговоров с близкими, которые узнали о ней после просмотра видео на YouTube.

Такая схема выгодна всем участникам: пользователи получают бесконечную ленту контента, YouTube — миллионы часов просмотров, а рекламодатели — монетизацию своих видео.

Что делает с этим YouTube

Принципы сообщества YouTube не запрещают авторам загружать видео с теориями заговора или вводящей в заблуждение информацией. Тем не менее, видеосервис делает точечные попытки предотвратить распространение конспирологических теорий.

В конце февраля сервис заблокировал несколько тысяч аккаунтов, которые публиковали видео о теориях заговора и распространяли различные мистификации. Под блокировку тогда попали и ролики, создатели которых рассказывали о самостоятельной сборке оружия или его применении. Двумя месяцами раньше YouTube объявил об увеличении штата модераторов до 10 тыс. человек.

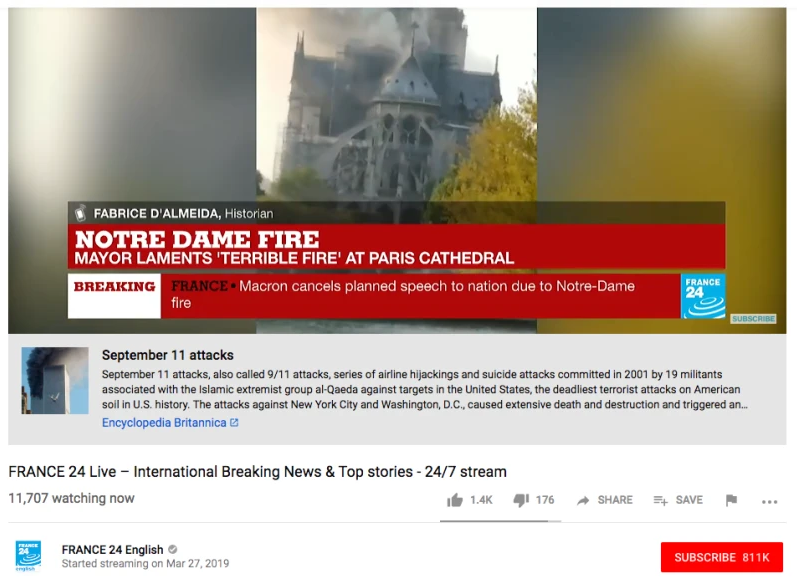

Кроме увеличения числа модераторов, в декабре прошлого года YouTube начал показывать ссылки на Википедию и другие достоверные источники при просмотре роликов с теориями заговора, чтобы ограничить распространение фейковых новостей и ложных теорий в видеосервисе.

Однако система работает не идеально — алгоритм YouTube принял трансляции пожара пожара в Нотр-Дам-де-Пари, который произошел 15 апреля, за кадры горящих башен-близнецов во время теракта в Нью-Йорке 11 сентября. Нейросеть показала пользователям статью из Википедии о теракте, в которой изложены несколько версий события — а затем модераторы вручную отключили показ статьи.

«Панели со статьями запускает алгоритм, и иногда он ошибается. Мы отключили панели в прямых трансляциях пожара в соборе Парижской Богоматери вручную», — сказал тогда представитель YouTube.

Другой пример — видео под заголовком «Любой рак можно вылечить за несколько недель», опубликованное iHealthTube.com в конце марта. В нем отсутствует панель со ссылкой на достоверный источник по теме ролика, при этом видео посмотрели около 7 млн раз.

Представители YouTube в ответ на серию запросов Bloomberg отказались пояснить, как работает система рекомендаций и насколько действенны предпринимаемые компанией меры по борьбе с распространение конспирологических видео. В целом руководство YouTube предпочитает уходить от прямого ответа на острые вопросы и предпочитает объяснять проблемы техническими недостатками алгоритмов или халатностью сотрудников, пишет агентство.

YouTube может перестать распространять конспирологические теории только в одном случае — если сделать это потребуют регуляторы нескольких стран или крупные рекламодатели. Последним уже удалось добиться того, чтобы видеосервис запретил монетизировать видео с изображением насилия.

Врезка

Если видео о плоской Земле, высадке США на Луну или неэффективности вакцинации невозможно будет монетизировать, их число резко снизится. Другие способы борьбы с роликами о теориях заговора едва ли окажутся эффективными — ни один разработчик ИИ до конца не знает, как он работает — и Google не исключение. А заново создавать рекомендательный алгоритм, который уже доказал свою работоспособность, компании нет никакого смысла.

В ответ на критику приоритетности роста компании над безопасностью пользователей Facebook объявила о намерении кардинально изменить свою политику работы с данными и алгоритмами социальной сети. Руководство YouTube пока пытается объяснить свои ошибки интересами общественности или инвесторов, а иногда и действиями отдельных сотрудников. И для Google неспособность видеосервиса решить свои проблемы остается одной из главных проблем.