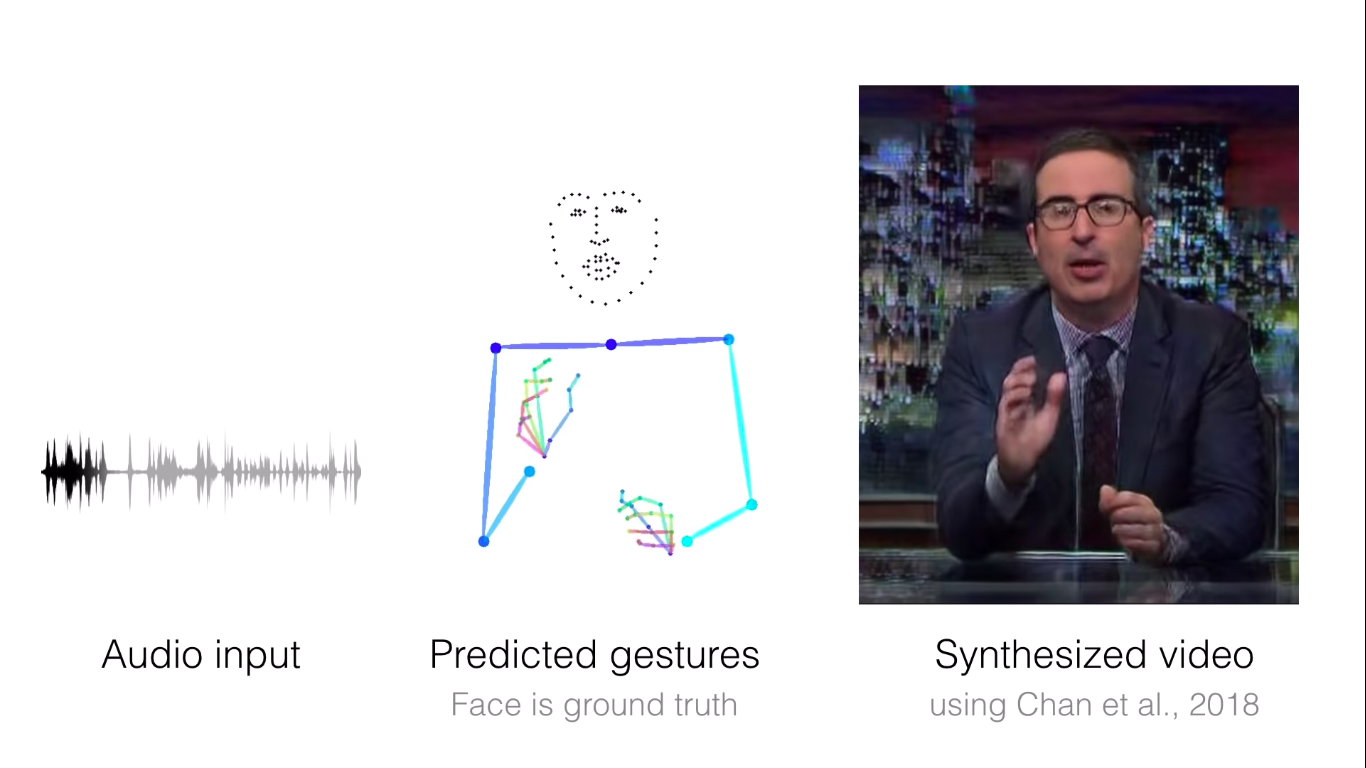

Исследователи собрали 144 часа видео выступлений десяти человек, в том числе монахини, учителя химии и пяти ведущих телешоу — Конана О’Брайена, Эллен Дедженерес, Джона Оливера, Джона Стюарта. Они использовали существующий алгоритм для получения фигур, предоставляющих положение тела, рук и кистей спикеров. Затем они обучали собственный алгоритм работе с данными, чтобы он мог предсказывать жесты, основываясь на звучании голоса.

Сгенерированные жесты были лучше, чем у похожего алгоритма, изначально предназначенного для того, чтобы предвидеть движения рук пианистов и скрипачей. Жесты ведущих шоу же были более уникальными, сообщили исследователи на конференции. В случае, когда ученые пытались обучить ИИ предсказанным жестам и добавить их в алгоритм, это привело к неточным результатам.

Следующим шагом команды ученых является прогнозирование жестов, основанных не только на аудиозаписях, но и на расшифровке. Потенциальные области применения включают в себя автоматическое создание анимированных персонажей.