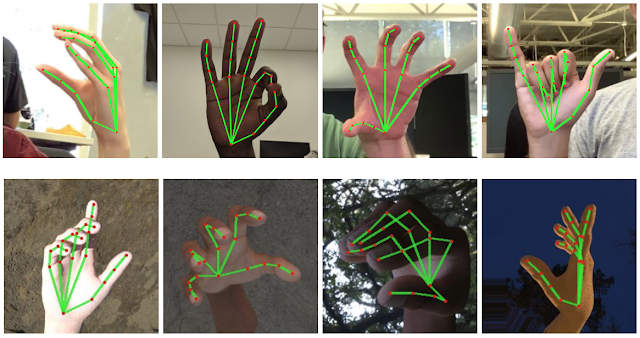

Google представила алгоритм, который позволяет с большой точностью отслеживать движения рук пользователя с помощью смартфона. Разработка позволит распознавать язык жестов и жестовые команды на включение, выключение смартфона или изменение уровня громкости, говорится в блоге компании.

Созданный инженерами компании алгоритм доступен в виде открытого исходного кода на GitHub, а также в приложении для Android. Система работает так — сначала она анализирует изображения с камеры на задней панели смартфона, определяет на них руку и анализирует ее положение.

Алгоритм работает не со всем изображением, а только с необходимой областью, которая ограничивается пределами руки — это значительно снижает вычислительные мощности, необходимые для работы алгоритма.

После определения кисти и разбивки ее на 21 точку алгоритм составляет двумерную или трехмерную модель, а затем и сравнивает положение пальцев и изгиб кисти с дата-сетом из 30 тыс. изображений.

Ранее Google запустила бета-версию функции навигации по картам дополненной реальности. Она доступна для всех устройств iOS и Android, имеющих поддержку AR на системном уровне. Несколько месяцев функция будет находиться в бета-тестировании, поскольку работа над ней еще не закончена.