В ООН предложили ввести мораторий на использование некоторых технологий искусственных интеллекта. Рассказываем, в чем причина беспокойства чиновников и как решение отразится на повседневной жизни людей.

С чего все началось?

В сентябре 2021 года вышел новый отчет ООН. Эксперты изучили, как страны и компании применяют системы искусственного интеллекта, которые влияют на жизнь и средства к существованию людей, не создавая при этом надлежащих мер защиты для предотвращения дискриминации и других видов вреда.

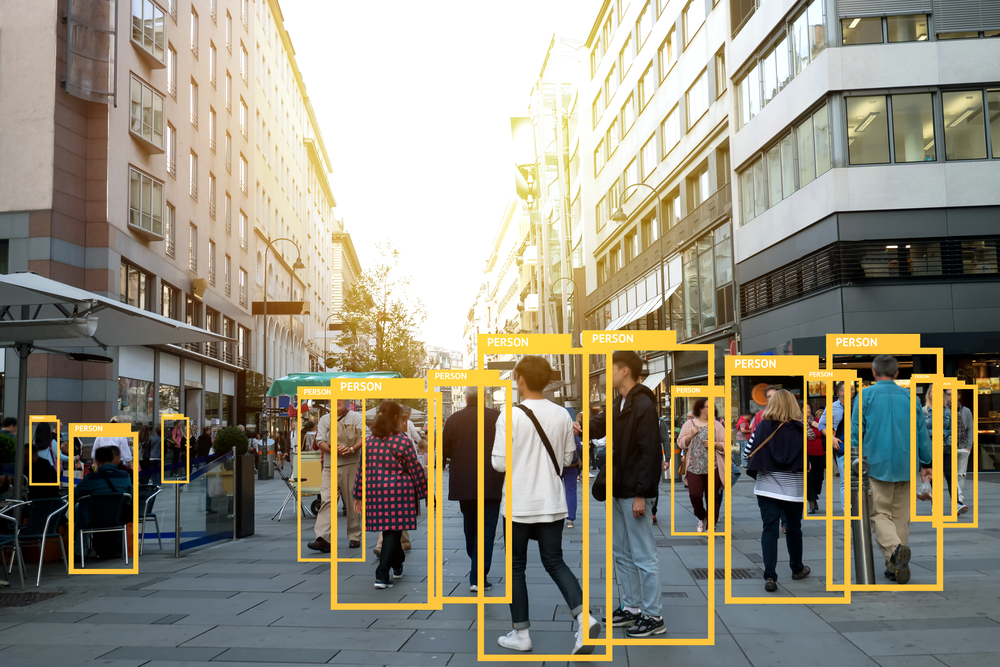

Вчера глава ООН по правам человека, Мишель Бачелет, призвала к мораторию на использование технологий искусственного интеллекта, которые представляют серьезную опасность для прав человека. В том числе систем сканирования лиц, отслеживающих людей в общественных местах. Она отметила, что страны должны немедленно запретить приложения ИИ, которые не соответствуют международному праву в области прав человека.

Где использование ИИ неприемлимо?

К приложениям, которые следует запретить, относятся государственные системы «социальной оценки», которые оценивают людей по их поведению, и определенные инструменты на основе ИИ, которые разделяют людей на группы, например, по этнической принадлежности или полу.

Технологии на основе искусственного интеллекта «могут быть силой добра», а также привести «к негативным, даже катастрофическим, последствиям», если используются без учета того, как они влияют на права человека, — говорится в заявлении Бачелет.

«Дело не в отсутствии искусственного интеллекта, — объяснила журналистам Пегги Хикс, директор по тематическому взаимодействию правозащитного центра ООН. Она обратилась ко СМИ, когда представляла отчет в Женеве. — Речь идет о том, что если ИИ будет использоваться в этих — очень важных — функциональных областях, связанных с правами человека, то это должно быть сделано правильно. И мы просто еще не создали структуру, которая обеспечивала бы это».

Бачелет не призывала к полному запрету технологии распознавания лиц, но отметила, что правительства должны прекратить сканировать поведение людей в режиме реального времени. Например, для оценки эффективности работы персонала. Необходимо убедиться, что технология точна, а ИИ непредвзят и соответствует стандартам конфиденциальности и защиты данных.

В отчете также высказываются опасения по поводу инструментов, которые пытаются определить эмоциональное и психическое состояние людей путем анализа их мимики или движений тела. Эксперты подчеркивают — такие технологии подвержены предвзятости, неверной интерпретации и не имеют научной основы.

«Использование государственными властями систем распознавания эмоций, например для выделения лиц для задержания или ареста полицией или для оценки правдивости заявлений во время допросов, рискует подорвать права человека, такие как право на неприкосновенность частной жизни, свободу и справедливость суд», — говорится в сообщении.

Где проблема применения ИИ стоит особенно остро?

Хотя названия конкретных стран в отчете не упоминаются, стоит упомянуть Китай. Напомним, в мае власти запустили в западном регионе Синьцзян программу тестирования на уйгурах камеры распознавания эмоций. И распознавания самих уйгуров. Напомним, Human Rights Watch еще в 2018 году опубликовала доклад о преследованиях мусульманского населения китайского региона Синьцзян. По данным организации, в последние годы там массово и зачастую безосновательно задерживают уйгуров, помещая их в тюрьмы и воспитательные лагеря; за миллионами людей организована постоянная видеослежка, а их социальное положение и судьба зависят от баллов, начисленных в системе «социального кредита».

Тем не менее, ключевые авторы отчета заявили, что наименование конкретных стран не входит в их полномочия и даже может быть контрпродуктивным.

«В китайском контексте, как и в других контекстах, мы обеспокоены прозрачностью и дискриминационными приложениями, которые адресованы конкретным сообществам», — объясняет представительница ООН Пегги Хикс.

Она процитировала несколько судебных дел в США и Австралии, где неправильно применялся искусственный интеллект.

Один из самых громких прецедентов в США — ситуация с Amazon. Эта корпорация является одним из центров разработок в области искусственного интеллекта. В 2017 году компания закрыла экспериментальный проект по найму сотрудников на основе ИИ, который вела около трех лет. Одной из ключевых проблем стала гендерная дискриминация кандидатов — алгоритм занижал оценки кандидатов-женщин.

Тем временем, в Австралии суд создал новаторский прецедент. Теперь системы искусственного интеллекта могут быть юридически признаны изобретателями в патентных заявках. Однако с таким решением согласились не все.

Что в итоге?

Рекомендации отчета отражают взгляды многих политических лидеров в западных демократический странах. Важно не только задействовать экономический и социальный потенциал ИИ, но и устранить растущую озабоченность по поводу надежности инструментов, которые отслеживают и профилируют людей.

Министр торговли США Джина Раймондо во время виртуальной конференции в июне поддержала опасения представителей ООН. «Страшно подумать, как можно использовать для дальнейшего усиления дискриминационных тенденций, — подчеркнула она сказала — Мы должны убедиться, что не допустим этого».

Так, европейские регулирующие органы уже предприняли шаги, чтобы обуздать наиболее рискованные приложения искусственного интеллекта. Предлагаемые правила, изложенные официальными лицами Европейского союза в этом году, будут запрещать некоторые виды использования ИИ, такие как сканирование черт лица в реальном времени, и жестко контролировать другие виды использования, которые могут угрожать безопасности или правам людей.

Читать далее

Уникальный катер превращается в подлодку за две минуты и незаметен для противника

Физики охладили атомы до самой низкой в мире температуры

Самую детальную модель Вселенной опубликовали онлайн. Ее может изучить любой желающий