Нейросеть может совершенствоваться во всем, например, в обмане. Ее учат синтезировать человеческий голос, создавать определенную внешность или подбирать такую комбинацию цветов, чтобы замаскировать любой объект. «Хайтек» объясняет, насколько хитрыми стали нейросети.

Нейросеть подделала речь, чтобы обмануть алгоритмы или других людей

Ученые из Чикагского университета решили проверить, насколько хорошо нейросеть может подделать голос человека. Чтобы узнать это, они использовали умные колонки, которые реагируют только на речь своего хозяина, а также аккаунты пользователей, например, в WeChat, где можно пройти авторизацию, сказав определенную фразу.

Исследователи разыграли ситуацию, когда у злоумышленника была запись голоса жертвы, которую можно найти в публичном доступе, а также возможность вживую пообщаться и записать речь. Отмечается, что нейросеть во время обучения учитывала не только голос, но еще и тембр с интонацией.

Далее авторы использовали уже обученные нейросети, которые можно найти в публичном доступе. Они выбрали две: SV2TTS и AutoVC. Для обучения моделей авторы использовали записи речи 90 людей из трех публичных датасетов: VCTK, LibriSpeech и SpeechAccent.

В результате исследователи примерно в 50% случаев успешно входили в аккаунт по синтезированному нейросетью голосу. Также при разговоре с алгоритмом человек не мог отличить настоящий голос от поддельного в 50%.

Нейросеть помогла нанести грим, чтобы обмануть систему распознавания лиц

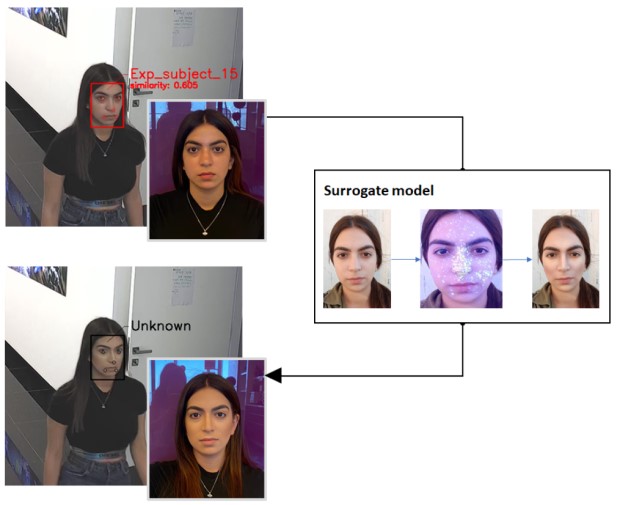

Израильские исследователи из Университета имени Бен-Гуриона сделали нейросеть, которая обманывает системы распознавания лиц с помощью грима. Она определяет те особенности внешности, которые чаще всего считывает устройство, а далее подбирает специальный макияж, который поможет сделать лицо неузнаваемым для системы.

Во время работы алгоритм сначала обрабатывает фотографии этого человека, а затем изображения других людей того же пола. Далее создается тепловая карта, на которой показаны основные области, где находятся отличительные черты, которые надо корректировать. После этого система создает изображение нового лица с макияжем и проверяет его на типичной системе распознавания лиц, пока она не перестанет реагировать на него.

Когда оптимальный вариант макияжа получен, его можно наносить. Авторы отмечают, что точность системы распознавания лиц снижается с 47,5 до 1,2%.

Нейросеть сделала универсальное лицо, чтобы обмануть систему идентификации

Исследователи из Израиля сделали нейросеть, которая генерирует изображения лиц, способных имитировать большое количество личностей для систем распознавания. По словам разработчиков, их алгоритм делает «универсальные» лица. Например, девять таких изображений могут заменить фото, как минимум, 40% людей из открытой базы.

В результате система генерировала лица, которые успешно идентифицировали как положительные в 40–60% случаев. Они использовали для этого всего девять сгенерированных фотографий.

Нейросеть обманывает зрение, создавая идеальный камуфляж

Ученые из Бристольского университета сделали нейросеть, которая анализирует окружающую среду и выбирает для объекта оптимальную окраску. Они отметили, что их алгоритм поможет эволюционным биологам понять, как менялась окраска различных живых видов, а также от чего она зависела.

Чтобы создать свой алгоритм, исследователи использовали набор генетических алгоритмов и глубокого обучения. У них получились миллионы шаблонов всего с несколькими цветами и небольшим объемом данных, полученных от людей-наблюдателей.

Метод протестировали на добровольцах, они должны были смотреть на изображения с предметами на разном фоне и нажимать кнопку, как только они увидят объект. С каждым разом алгоритм все уменьшал набор цветов и узоров до тех, которые труднее или легче всего увидеть. В зависимости от того, хотим ли мы найти окраску для маскировки или для того, чтобы быть заметным.

Нейросеть, которая обманывает другие нейросети

Ученые создали нейросеть, которая пытается бороться с классификаторами фейков. Новый алгоритм может вставить в изображение или видео специальный шум, который заставляет другие классификаторы распознавать контент как оригинальный и не отредактированный.

Речь идет о дипфейках — это контент, в котором человеку специально меняют лицо или мимику, например, на известную звезду, актера или политика, чтобы скомпрометировать человека на том, чего он никогда не делал или не говорил. Закономерно после дипфейков появились нейросети, которые распознают, было ли видео или фото отредактировано.

На следующей ступени развития этого противостояния появились нейросети, которые обманывают алгоритмы распознавания дипфейков. Нейросеть-обманщик может потенциально приспособиться к любым, в том числе еще неизвестным классификаторам дипфейков. В результате такому алгоритму удается обмануть классификаторы в 99% случаев при условии, что видеорезультат не будут сжимать. В случае сжатия процент успешности падает до 60–90%.

Читать далее

ИИ решил биологическую задачу, над которой ученые бились 50 лет

Миллисекунда вместо 30 трлн лет на задачу: Китай представил новый квантовый компьютер

Ученые ищут людей, которые не могут заразиться COVID-19. На основе их данных сделают лекарство