Искусственный интеллект (ИИ) — это огромные возможности, но и большой риск для человечества. Исследователи теперь могут с легкостью использовать этот инструмент для экспериментов, которые раньше были недоступны, но что если алгоритмы выйдут из-под контроля? Александр Ханин, генеральный директор MTS AI и сооснователь VisionLabs, рассказывает, как сделать ИИ другом, а не врагом.

Цифровизацию не остановить

Цифровизация городов только набирает свои обороты. Уже никого не удивляют умные камеры, которые наблюдают за обстановкой на улицах мегаполисов, доступ к Wi-Fi в общественных местах, услуги по оформлению документов и получению медицинской помощи в дистанционном режиме. Но искусственный интеллект уже проникает и в транспортную инфраструктуру. Оплатить поездку на станциях московского метро можно с использованием биометрических данных. Только за первые полтора месяца действия Face Pay (автоматический пропуск пассажира через турникет с распознаванием по лицу) ей воспользовались более 160 тыс. человек. Подключиться к этой системе несложно: пассажиру нужно привязать свою карту «Тройка» к приложению «Метро Москвы», а затем загрузить в него свое фото. По прогнозам экспертов, через 2-3 года до 15% пассажиров метрополитена будут пользоваться Face Pay, а с учетом текущих сложностей с оплатой через Apple Pay и Google Pay можно предположить, что таких пассажиров будет в разы больше.

Это очень удобно: для прохода в метро достаточно посмотреть в камеру, не нужно доставать кошелек, смартфон или банковскую карту. Но у скептиков новые технологии вызывают опасения. Они считают, что доверять проверку и анализ биометрических данных искусственному интеллекту и стороннему провайдеру очень опасно. Неизвестно, в чьих руках они окажутся и как их можно использовать против самого владельца, вдруг кто-то возьмет кредит под видом другого человека или совершит преступление, воспользовавшись биометрическими данными. Писатели идут еще дальше и предупреждают о еще больших неприятностях: а вдруг ИИ восстанет и начнет охотиться на людей, выслеживая их по сетчатке глаза, сканированной в метро. Но эксперты отмечают, что угроза искусственного интеллекта в массовом сознании очень сильно преувеличена.

Невозможный бунт машин

«Интеллект» в термине ИИ — маркетинговое преувеличение. Математически четких критериев того, что считать разумом, до сих пор нет, но большинство биологов и философов сходятся на том, что интеллект — это способность успешно решать нетривиальные задачи. На более высоком уровне — самостоятельно ставить перед собой ранее не встречавшиеся задачи и решать их. Никакая компьютерная система в обозримом будущем на это способна не будет. Никто никогда не ставил цель создать так называемый сильный ИИ (Strong AI), потому что потенциальный экономический эффект от такой разработки меньше необходимых для нее средств.

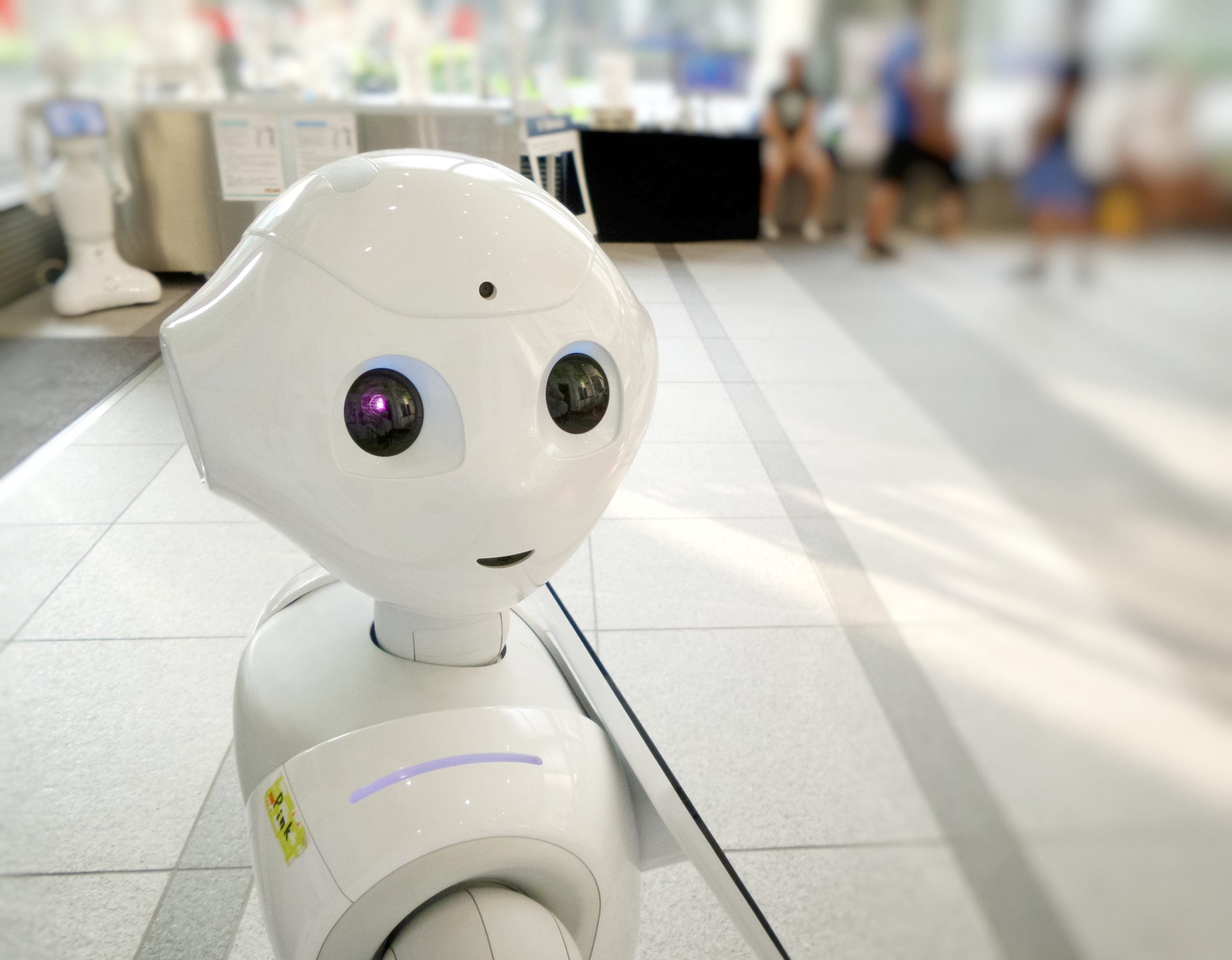

Сегодня под ИИ де-факто понимают разные реализации систем машинного обучения. Они умеют находить закономерности между данными и распознавать образы. К примеру, трехлетний ребенок уверенно отличает на фото кошку от собаки. Того же добьется и нейросеть, когда ей «скормят» несколько десятков тысяч снимков, часть которых будет корректно подписана «кошка», а часть «собака». Уже сегодня ИИ умеет распознавать лица, выискивая характерные черты, и делает это с точностью в 96–98% — таких результатов можно добиться, даже если люди носят стандартные медицинские маски.

Доверяй, но кому?

Что происходит после того, как машина идентифицирует человека? Это зависит от тех, кто программировал систему и ставил ИТ-специалистам задачи. Можно использовать привязку отождествленного человека к базе данных и открыть перед ним турникет метро, списав с его счета сумму за проход. Можно соотнести его биометрию с другой базой — и, задав синтезированным голосом вопрос «Вы действительно хотите взять этот кредит?», дождаться ответа «Да» и перевести на его счет оговоренную сумму. В любом случае следующие за распознаванием лица решения не принимает ИИ сам по себе, — они зависят от алгоритмов, реализованных живыми программистами.

Создавшая резонанс китайская система «социального кредита» — это лишь огромная база данных (точнее, несколько разрозненных баз), где каждому зарегистрированному гражданину, компании либо госучреждению ставится условный балл. «Хорошее» поведение выражается в росте этого балла, «плохое» — в его снижении.

Такая система может действовать автоматически: она распознает лицо человека в потоке и тут же либо позволяет, либо запрещает ему выполнять какие-то действия: например, оформить кредит, купить авиабилет. Но сами правила, по которым машина принимает то или иное решение, определяются людьми. Аналогичные системы меньшего масштаба работают во множестве корпораций, необязательно китайских, и часто реакции их на одно и то же действие кардинально различаются из-за разных подходов разработчиков.

Сама по себе биометрия на основе ИИ не хороша и не плоха. Технически нет никакой разницы между масштабными каталогами докомпьютерной эры (в 1944 году картотека ФБР насчитывала 23 млн карточек) и биометрическими базами данных современности. Компьютер находит нужную информацию несопоставимо быстрее человека — вот почему мгновенное распознавание по лицу в толпе повергает обывателя в шок. Но это лишь психологический эффект, а реальные последствия действий цифровой системы определяет то, как будут обращаться с полученными ею данными имеющие к ним доступ люди.

Впрочем, нет оснований опасаться тотальной подмены живого человека его «цифровым двойником» — той самой записью в компьютерной базе данных. Одно дело, когда некто с низким уровнем социального кредита копошится у дальней полки в магазине: алгоритм контроля за поведением людей в торговом зале, получив сигнал от видеокамеры с распознаванием образов, сопоставит лицо посетителя с полицейской базой — и выдаст охране рекомендацию подойти к подозрительной личности. Но совсем другое — когда социальный кредит человека внезапно обнуляется: либо вследствие компьютерной ошибки, либо из-за чьих-то злонамеренных действий.

Разработчики по всему миру хотят создать надежный и проверяемый ИИ, логические «умопостроения» которого в процессе принятия решений фиксируются в явном виде и доступны для верификации оператором-человеком. Общество приступило к формированию единых критериев этичности действий искусственного интеллекта: можно упомянуть российский кодекс этики ИИ или схожий по духу законопроект Евросоюза. Они позволят снизить вероятность появления ошибок или реализации злого умысла при обращении с «цифровыми двойниками».

Технологии искусственного интеллекта продолжат развиваться: попытки остановить прогресс бессмысленны. Обществу следует лишь позаботиться о том, чтобы удобные и полезные цифровые инструменты применялись на пользу и становились средством не тотального алгоритмизированного контроля, а увеличения комфорта и безопасности.

Читать далее

«Пятый элемент» существует: новый эксперимент подтвердит, что информация материальна

Жуткие звуки и загадочные существа: самые странные находки в Марианской впадине

Посмотрите на самый качественный снимок Солнца: он состоит из 83 млн пикселей