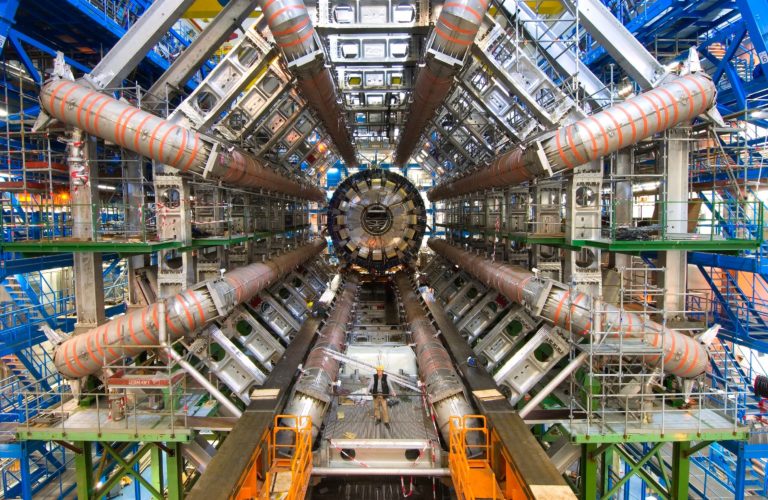

Синергия физиков и айтишников стала неизбежной историей: исследователи, работающие на Большом адронном коллайдере, нуждаются в симуляции огромного количества событий и обучении нейросетей, которые способны генерировать аномалии, чтобы впоследствии их идентифицировать в процессе реальных экспериментов. Иначе говоря — обнаруживать те частицы и те распады, о которых нам пока еще неизвестно. Например, частицы темной материи. «Хайтек» узнал у Андрея Устюжанина, заведующего научно-учебной лабораторией методов анализа больших данных в НИУ ВШЭ, как ML-алгоритмы помогают в исследованиях CERN и почему так трудно найти аномалии.

Андрей Устюжанин — заведующий научно-учебной лабораторией методов анализа больших данных в НИУ ВШЭ. Руководитель совместных проектов «Яндекса» и CERN. Участвует в разработке сервисов EventIndex и EventFilter, которые «Яндекс» предоставляет для эксперимента LHCb с 2011 года.

Окончил МФТИ в 2000 году, кандидат физико-математических наук. Один из судей международного финала Microsoft Imagine Cup, до этого был ментором команды МФТИ, выигравшей кубок в 2005 году.

Как ищут аномалии в данных Большого адронного коллайдера

— Что такое аномалии в данных?

— Если говорить о данных, полученных с помощью Большого адронного коллайдера (БАК), это могут быть открытия, которые не укладываются в стандартные представления о том, как проходят там распады частиц, возникающие после столкновения протонов. Эти открытия и будут аномалиями.

Например, если мы говорим про котировки активов на бирже, то там аномалии могут быть связаны с тем, что некий хедж-фонд решил прокачать актив или Wall Street Bets решили подзаработать и устроили свой распределенный хедж-фонд. То есть и физика совершенно разная, и проявление этой физики в данных тоже не похоже другие кейсы.

Поэтому если говорить про аномалии, то сначала нужно понять, про какие данные и какую физику мы говорим.

— Давайте тогда уточним с фокусом на коллайдеры.

— Здесь немного проще, хотя тоже возникает развилка. Дело в том, что есть данные о том, что за процессы происходят с частицами внутри детектора. А есть данные о том, как работает этот коллайдер. Людей, которые интересуются прежде всего открытием новых частиц или законов, в основном интересует первый тип данных. Но дело в том, что все что происходит по физике, проходит через довольно длинную цепочку сбора и обработки этой информации. И если какой-то из узлов этой цепочки начинает вести себя не так хорошо, как мы представляли, то есть выходит за определенные рамки допустимого, это вносит искажение в измерения. Мы можем увидеть аномалии в том месте, в которых их, в общем-то, в физике и не было.

Чтобы избежать таких неприятных событий, люди пишут специальные системы контроля качества данных, которые мониторят все данные в измерительных инструментах и пытаются исключить из рассмотрения те периоды времени, когда есть подозрение о том, что что-то идет не так.

Один из примеров, про который любят рассказывать физики из БАК, заключался в том, что на ранних этапах работы коллайдера они заметили аномалии, которые не вписывались в физические представления. Еще был не БАК, а его предыдущая версия. В итоге физики выяснили, что корреляция очень серьезная с расписанием движения поездов на железной дороге, которая находится неподалеку. И если вносить коррективы, связанные с этими колебаниями, то получается нефизичная картина мира.

Необходимо учитывать внешние факторы и уметь понимать, какие из них нужно правильным образом компенсировать. Самое простое решение: давайте выкинем те данные, которые не укладываются в привычную картину мира. Более сложные истории заключаются в том, чтобы эти аномалии попробовать с использованием понятных и физических принципов вернуть в русло нормальных данных и попытаться извлечь из них пользу.

Выкидывать данные — это трата бюджетных средств. Каждый килобайт-мегабайт имеет определенную цену.

Андрей Устюжанин, заведующий научно-учебной лабораторией методов анализа больших данных в НИУ ВШЭ

— И, соответственно, как с помощью системы с машинным обучением можно обнаружить в этих данных ту самую аномалию?

— Есть две группы таких алгоритмов, которые работают с аномалиями. В первой группе методов одноклассовой классификации находятся алгоритмы, которые используют информацию только о тех событиях, которые помечены как хорошие. То есть они пытаются построить выпуклую оболочку, которая охватывает все, что мы считаем правильным. Логика такая: все, что выходит за рамки этой оболочки, будем считать аномалиями. То есть, например, 99% данных такой оболочкой покрываются, а все остальное выглядит как что-то подозрительное.

Другая группа алгоритмов опирается на частичную разметку того, что мы считаем неправильным. По сути есть набор событий, о которых точно известно, что это нежелательные результаты. И тогда поиск аномалий сводится к задаче двухклассовой классификации. Это обычный классификатор, который может быть построен на принципах нейронных сетей или деревьях решений.

Нюанс заключается в том, что обычно в задачах аномалий выборка не сбалансирована. То есть количество позитивных примеров значительно превосходит количество негативных. В таких условиях стандартные алгоритмы классификации могут работать не так хорошо, как хотелось бы. Функция потерь по умолчанию одинаково расценивает примеры, которые правильно классифицируются, и может не обратить внимание на то, что среди 10 000 правильных результатов есть сотня тех, что квалифицировались неправильно. Эта сотня как раз представляет те отрицательные примеры, которые наиболее интересны. Понятно, что с этим можно бороться, например, присвоив отрицательным примерам больший вес, и учитывать ошибки с их классификацией с гораздо большим весом.

Функция потерь — функция, которая в теории статистических решений характеризует потери при неправильном принятии решений на основе наблюдаемых данных.

Вклад нашей лаборатории в решение задачи обнаружения аномалий заключается в предложении методов, которые сочетают в себе особенности первого и второго подхода. То есть задача работы с одноклассовой и двуклассовой классификацией. Такое совмещение становится возможно, если построить генеративные модели аномальных примеров.

Используя такие подходы, как генеративные состязательные сети или нормирующие потоки, мы можем научиться восстанавливать те примеры, которые помечены как отрицательные, и генерировать дополнительную выборку, которая позволит обычному классификатору работать с дополненной синтетической выборкой более эффективно. Такой подход хорошо себя ведет и в случае табличных данных, и случае работы с изображениями. Про это была статья в прошлом году, которая описывает, как такая система строится, и приводит практические примеры ее использования.

— Вы сказали про работу с изображениями. Как это работает в данном случае?

— Есть примеры, на которых мы показывали работу этого алгоритма. Просто выбирали один из классов изображений: например, рукописные цифры. И говорили, что ноль — это некая аномалия. И просили нейронную сеть, которая принимает решение о том, что нолики не похожи на все остальное, отнести к негативному классу. Естественно, это могут быть не только нули, но и, например, цифры, внутри которых есть замкнутые циклы — 068 — или цифры с горизонтальными пересечениями. Или просто изображения, повернутые на какой-то угол по отношению ко всей остальной выборке.

Есть датасет, который называется омниглот — буквы, написанные разными шрифтами. Там огромное количество шрифтов: из Futurama, готические, рукописные из непопулярных алфавитов — санскрита или иврита. Можно сказать, что буквы на санскрите — это аномалия, буквы, написанные определенным почерком, — тоже.

Мы просим систему научиться отличать все остальное от этих аномальных символов. Главное, что их гораздо меньше, чем всего остального. В этом заключается сложность работы с ними для обычных алгоритмов машинного обучения.

Симбиоз физики и ИТ: как применяют машинное обучение в исследованиях БАК

— Какие задачи БАК решаются с помощью машинного обучения?

— Одна большая задача, с которой мы работаем, заключается в ускорении вычислительных процессов, которые симулируют физические столкновения и распады частиц. Дело в том, что принятие решения о том, похожи данные события на определённые физические распады или нет, принимается после анализа довольно большого количества симулированных распадов. Мы можем просимулировать физику при определенных внешних параметрах с хорошей точностью и сказать, какими наблюдаемыми характеристиками будут описываться правильные сигнальные события, например, распад бозона Хиггса.

Но есть определенные оговорки: не всегда мы знаем параметры, при которых нужно сгенерировать эти распады. Как правило, есть определенное представление об этом. И задача поиска правильной физики заключается в том, чтобы отличить сигнальные от фоновых событий, которые могут быть связаны либо с неправильной работой алгоритмов восстановления, либо с физикой других процессов, которые очень похожи на то, что мы пытаемся найти. С этой задачей хорошо справляются алгоритмы машинного обучения, но это довольно известная история.

Но для обучения таких алгоритмов требуется довольно большая статистическая выборка симулированных событий, а вычисления этих синтетических данных требует определенных ресурсов. Потому что на симуляцию одного события уходит порядка минуты или даже десятка минут вычислительного времени современных компьютерных центров. Из-за того, что количество реальных событий, с которыми будут работать физики, увеличится на порядки в ближайшие годы, количество синтезированных событий тоже должно увеличиться. Сейчас вычислительных ресурсов едва хватает на то, чтобы покрыть нужды исследователей. Потому что для симуляции одного события приходится рассчитывать взаимодействие микрочастиц со структурой детектора и симулировать тот отклик, который мы увидим на сенсорах этого детектора с очень высокой точностью.

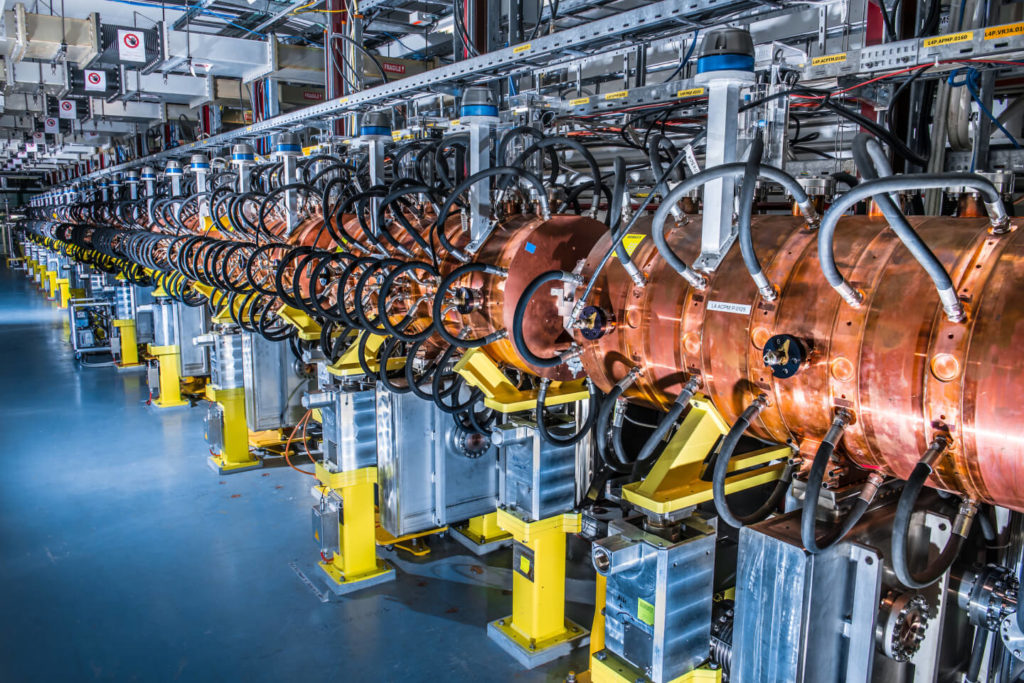

Идея ускорения заключается в обучении нейросети на событиях, которые были сымитированы с помощью сертифицированного пакета — GMT 4, с помощью которого симулируется все, что происходит внутри детекторов коллайдера. Эта нейронка научится сопоставлять входы, параметры частиц, которые мы хотим просимулировать, и выходы — те наблюдаемые характеристики, которые выдает детектор. Нейросети сегодня уже достаточно хорошо справляются с задачей интерполяции данных. И несколько проектов нашей лаборатории нацелены именно на это. То есть на восстановление характеристик распадов по имеющейся синтетической выборке, то есть сделать такую синтетику второго порядка. Но есть нюанс: преимущество нейросетей заключается в том, что мы можем их донастроить с использованием реальных данных. То есть сделать эту настройку более аккуратной под конкретный физический распад.

Люди, которые занимаются полноценной физической симуляцией, на это тратят свое время и силы, но с нейронками это получается чуть менее трудозатратно. И по результатам, которые мы делали для эксперимента LHTV в CERN и проекта с экспериментом MPD в Дубне на ускорителе Nica, стало ясно, что нейросети могут достигать очень высокой точности покрытия фазового пространства симулированных событий. Они значительно ускоряют процесс вычислений: на порядки и даже сотни быстрее, чем честная симуляция.

— А как происходит само обучение нейронной сети?

— Каких-то отличий в процессе обучения нет. Но есть одна особенность: для нейросети, кроме обучающей выборки, необходимо сформулировать критерии качества, то есть задать функцию потерь, которая бы максимально соответствовала той задаче, с которой эта сетка должна хорошо справляться. Вдобавок качество работы такой нейросети оценивается не исследователями: его можно адекватно оценить с точки зрения шагов вычислений, которые происходят на более позднем этапе обработки данных.

Определить, хорошая симуляция или нет, мы сможем только после того, как пропустим события через цепочку их анализа, реконструкции, и поймем, что из них восстанавливаются те же характеристики, которые мы заложили в них изначально. Это означает, что, например, использовать простую метрику MSE Mean Squared Error недостаточно.

MSE Mean Squared Error, среднеквадратичная ошибка — измеряет среднеквадратичную разницу между оценочными значениями и фактическим значением.

Поведение нейросети нужно оценивать и дальше, в особенности на диапазонах параметров, которые, возможно, не присутствовали в обучающей выборке. Построение таких моделей, которые хорошо себя ведут за пределами значений параметров, известных на этапе обучения, — большая и теоретическая задача.

Нейросети хороши в тех местах, в которых они знали что-то на этапе обучения. За их пределами они могут выдавать все, что им заблагорассудится. В нашем случае это особенно чувствительно, потому что от этого зависит правильность физической интерпретации окружающей нас действительности.

— То есть нейросеть занимается поиском редких событий, которые могут произойти на коллайдере?

— На основе работы генеративных моделей, то есть сначала говорим про синтез всего того, что может происходить. Мы это делаем с помощью миниатюрных моделей. И на выходе таких сетей мы можем построить модель, которая будет искать, что нам нужно: то, что мы сумели сгенерировать на генеративной нейросети.

Как искать темную материю и зачем для этого нужны нейросети

— Можно ли аналогичный принцип поиска приложить к темной материи?

— Дело в том, что темную материю можно искать разными способами. Один из способов заключается в построении правильного детектора, который может достаточно хорошо изолироваться от эффектов обычной материи. То есть заблокировать сигнал, который приходит от известных физикам частиц. Это просто метод исключения: если детектор видит что-то, кроме шума, значит, он видит то, что мы раньше не видели никогда. Одна из возможностей будет заключаться в том, что это частицы темной материи.

Если, например, частица темной материи распадается на частицы, с которыми мы знаем, как взаимодействовать, и понятно, что следы распада не могли появиться ниоткуда, кроме как из нее, то можно предположить, что эта частица темной материи действительно была.

Такие эксперименты обсуждаются и планируются. Один из них называется SHiP (Search for Hidden Particles). И, кстати, для такого эксперимента те подходы, о которых я говорил, также применимы. Там требуется симуляция и алгоритмы распознавания редких подходов. Но поскольку светимость этого эксперимента гораздо меньше (светимость — это количество частиц, которое планируют детектировать в единицу времени), то необходимость симуляции большого количества однотипных событий не такая острая, как в случае с детекторами адронного коллайдера. Хотя, например, задача, связанная с оценкой качества работы защитной системы от известных физике частиц, требует симуляции довольно большого количества событий. Это необходимо для того, чтобы убедиться, что защита работает хорошо при колоссальном количестве прилетающих частиц разного вида.

SHiP — это эксперимент, направленный на поиск скрытых частиц, в том числе частиц темной материи, в отфильтрованном магнитными полями, пятиметровым слоем бетона и металла потоке частиц от ускорителя SPS.

Есть и другие способы поиска темной материи, связанные с наблюдениями за космическими явлениями. В частности один из подходов заключается в построении чувствительных элементов, которые распознают направление очень слабо взаимодействующих частиц в зависимости от угла падения этой частицы. Логика эксперимента заключается в том, что можно поместить чувствительные элементы так, чтобы они были ориентированы по вектору движения Солнечной системы, то есть к созвездию Лебедь. Тогда мы сможем отличать частицы, которые движутся в системе координат Земли, от частиц, которые движутся по-другому. Подобно неподвижному эфиру, который распределен в космическом пространстве по своим законам, никак не связанным с ориентацией и направлением движения планет. Просто вместо эфира предполагается, что существуют частицы темной материи. Они могут слабо взаимодействовать с датчиками нашей нашего эксперимента. И, анализируя их показания, можно вывести закономерности угловых распределений взаимодействующих частиц. Если увидим, что есть серьезная составляющая, которая не зависит от положения Земли в пространстве, это будет свидетельствовать о существовании ранее неизвестных частиц. И, возможно, это будут кандидаты на частицы темной материи.

В таком эксперименте симуляция достаточно важна, потому что для построения алгоритма распознавания сигнальных событий нужно представлять, как выглядит интересующий нас сигнал. Поэтому задачи, связанные с быстрой симуляцией и поиском аномалий, там актуальны и применимы.

Говорят на разных языках, но цели общие

— Поговорим о работе в CERN. Каково человеку из ИТ работать с физиками? Какие особенности связаны с работой в таком кросс-научном пространстве как БАК?

— Хороший вопрос. Действительно люди разговаривают на разных языках: доходит до того, что одни и те же понятия графически изображаются разными способами. Например, ROC-кривые, к которым привыкли специалисты по машинному обучению, в физике принято чертить повернутыми на 90 градусов. А координаты называются не True Positive Rate и False Negative Rate, а Signal efficiency и Background rejection. При этом, если Signal efficiency — это все еще Precision, то Background rejection — это единица минус True Negative Rate.

ROC-кривая (от англ. receiver operating characteristic, рабочая характеристика приемника) — график, позволяющий оценить качество бинарной классификации. Отображает соотношение между долями объектов от общего количества носителей признака, верно классифицированных как несущие признака, и долями объектов от общего количества объектов, не несущих признака, ошибочно классифицированных как несущие признак.

Понятно, что такие вещи могут находиться на поверхности, и к ним относительно просто можно привыкнуть, но основные сложности заключаются в понимании некоторых основных предположений, от которых отталкиваются исследователи, когда пишут свои статьи. И, как правило, они находятся за рамками того, о чем пишут. То есть это некоторое сокровенное знание, которое передается в процессе обучения человека в аспирантуре, в процессе работы над его исследовательскими проектами, оно формируется в его сознании.

Для людей из другой области науки — это как другая культурная среда. Для них эти предположения могут быть не настолько очевидными. Из-за того, что лексикон оказывается достаточно обширным и отличающимся, построение диалога может затянуться или вовсе быть непродуктивным. Поэтому здесь в качестве рекомендаций, наверное, можно посоветовать либо просить людей выйти за рамки того, к чему они привыкли, и сформулировать задачу в максимально отвлеченных терминах от физики. Отчасти мы этим занимаемся, когда организуем соревнования в рамках нашей олимпиады IDAL. В процессе диалога мы находим такую постановку, которая бы не требовала глубокого погружения в физику, но в тоже время была бы интересна для специалистов из машинного обучения.

В этом году у нас был совместный проект с итальянской лабораторией, которая как раз ищет темную материю. Они предоставили синтетические данные для олимпиады по поиску этой темной материи. Там правда нет никакой темной материи, потому что симулировались распады известной физики: столкновения электронов и ионов гелия. Но столкновения частиц темной материи могут быть очень похожи на какие-то из этих столкновений. Их очень сложно симулировать, а интерпретировать еще сложнее. Поэтому специально для людей, не являющихся специалистами в этой области, мы решили не вытаскивать эти данные и ограничиться только теми, которые будут похожи. Алгоритмы, которые мы увидим, работают на приближенных данных, но могут быть применены и к настоящим.

Если подытожить, то один способ — это договориться о понятных терминах для всех, а другой — потратить время и силы, пройти летние школы, поучаствовать в практических исследовательских проектах.

Книги о машинном обучении и физических экспериментах, которые советует Андрей Устюжанин:

- Deepak Kar, Experimental Particle Physics: Understanding the measurements and searches at the Large Hadron Collider.

- Ilya Narsky, Statistical Analysis Techniques in Particle Physics: Fits, Density Estimation and Supervised Learning.

- Giuseppe Carleo, Machine learning and the physical sciences.

— Есть ли противоречия между ценностями физиков и айтишников: кому-то, к примеру, важнее характер взаимодействий, или, напротив, точность?

— Если говорить конкретно про точность, наверное, нет неоднозначности. Но это скорее из-за того, что айтишники не понимают природу данных. Просто, если мы измерили данные с точностью до миллиметра, то считать площадь с точностью до квадратных микронов никакого смысла нет. В случае работы сложных нейросетей мы сталкиваемся с тем, что они выдают информацию с точностью до последнего знака в мантиссе, но смысла в этих знаках не больше, чем в той точности, что была на входе.

Ну и, может быть, общее пожелание для людей, которые занимаются оценкой точности моделей, — это выдавать не только абсолютные характеристики, но и пределы допустимых диапазонов или разброс, в которых эти значения были получены. На самом деле хорошая рекомендация не только для тех, кто взаимодействует с физиками или с биологами. Это в принципе правильный способ ведения представления полученных результатов.

А если говорить про то, насколько могут быть разными ожидания с одной и с другой стороны, то это все рабочие вопросы, на самом деле. При наличии заинтересованности с обеих сторон они решаются просто и хорошо. То есть у физиков в широком смысле машинное обучение сейчас востребовано, потому что предоставляет более точные инструменты по работе с их данным. И в обратную сторону это работает, потому что для специалистов из машинного обучения бывает гораздо интереснее смотреть, как их алгоритмы помогают в открытии новых частиц, например, как в случае с нашей лабораторией. Мы долго работали над тем, чтобы сделать алгоритм, который бы определял тип частицы. И недавно была новость об открытии новых тетракварков, и наши алгоритмы приняли непосредственное участие в их открытии.

Поэтому для людей из ИТ, условно из Data Science, Computer Science, чувствовать полезность разрабатываемых ими алгоритмов очень важно. Поэтому на нашем факультете, например, существует Международная лаборатория биоинформатики.

Такие взаимодействия со временем становятся все более и более нормальными. Я не знаю, можно ли уже сейчас считать их мейнстримом или нужно еще подождать, но так или иначе эта история неизбежна. Даже если посмотреть на воркшопы, организуемые в рамках современных ведущих конференций по искусственному интеллекту, то воркшоп по применению ИИ в физических науках занимает лидирующее место по количеству заинтересованных людей.

Читать далее:

Американский спутник «разглядел» с Земли необычное послание

Опубликовано видео с ракеты, которую запустили из экспериментального ускорителя

Чудовище в центре нашей Галактики: посмотрите на фото черной дыры в Млечном Пути