Искусственный интеллект доказал свою эффективность не только в повседневной жизни, но и в бизнесе. Однако ИИ, как и другие технологии, работающие с большими данными, помимо колоссальных положительных качеств, несет и определенные риски. В первую очередь они связаны с безопасностью информации. Разбираемся, на что обращать внимание при общении с нейросетями и как не допустить утечку: рассказывает Дмитрий Крюков, руководитель отдела машинного обучения «МТС Линк».

Какие данные относятся к конфиденциальным

Для общего понимания контекста начнем с определений. Конфиденциальная информация — это сведения, разглашение которых может нанести ущерб физическим и юридическим лицам. К ним относятся:

- персональные (паспортные, СНИЛС, медицинские, данные о доходах), а также номер телефона, адрес email и другие контакты;

- корпоративные (операционные процессы, внутренняя аналитика, данные о клиентах и сотрудниках, юридические риски);

- коммерческие тайны (стратегические активы, технологические секреты, рыночные инсайты, финансовые и другие отчетности);

- классифицированные (государственные и военные) — но о них поговорим в другой раз.

Сохранность этих сведений регулируется законом.

В современном мире большинство пользователей понимают, почему важно не разглашать личную информацию, к чему могут привести утечки, а корпорации, в свою очередь, имеют целые системы для защиты безопасности данных. Учитывая это, возникает закономерный вопрос: каким образом конфиденциальные данные оказываются во власти искусственного интеллекта?

Как личная информация попадает к нейросетям

Стоит обозначить, что речь в первую очередь идет об открытых ИИ-моделях — таких, как ChatGPT (Open AI), Claude (Anthropic), DeepSeek и Midjourney одноименных компаний, Gemini (Google), Copilot (Microsoft) и других.

Они развиваются за счет машинного обучения — обработки огромных массивов информации, включая публичные источники: разные веб-сайты, соцсети, статьи и документы, изображения и видео из открытых платформ. Помимо бесплатных источников, разработчики приобретают и лицензионные датасеты. Специализированные модели тренируются в рамках узких направлений (медицинских, юридических). Персональная информация может по ошибке затесаться, даже если данные обезличены: анализируя совокупность параметров, ИИ может восстановить личность человека или коммерческий контекст.

Другая ситуация — когда пользователи сознательно вносят собственные данные, взаимодействуя с открытыми ИИ-сервисами:

- загружают документы для анализа информации, резюме или проверки грамотности;

- ставят задачу написать подробный отчет из конкретных финансовых показателей;

- сообщают голосовым помощникам (например, «Алисе» от «Яндекса» или «Марусе» от Mail.ru) свое имя, телефон, адрес для вызова такси;

- передают номера платежных карт цифровым финансовым помощникам разных банков;

- вносят личные сведения в медицинских чат-ботах для врачей (к примеру, от Cleverbots);

- пропускают всевозможные данные через переводческие сервисы;

- дают нейросетям доступ к персональной и корпоративной почте, если подключают соответствующие услуги.

Популярные облачные сервисы, такие, как «Яндекс Диск», «Google Диск» и OneDrive, тоже используют алгоритмы ИИ. В числе прочего они применяют технологии оптического распознавания образов и текста (OCR), чтобы находить документы, фотографии и другие файлы по содержимому. При этом в них хранятся тонны частной и корпоративной информации, и таким образом они имеют к ней прямой доступ.

Делиться можно, но осторожно

Следует отметить, что делиться данными с искусственным интеллектом далеко не всегда означает ставить под угрозу их безопасность. Нейросети продолжают завоевывать мировую симпатию именно благодаря своим удивительным свойствам, и отказываться от их помощи вовсе не стоит.

Они умеют обрабатывать неподъемные массивы данных, автоматизировать десятки разносторонних процессов, ускоренно генерировать «километры» текстового и визуального контента, преодолевать языковые барьеры и сводить к минимуму человеческие ошибки. А еще они постоянно учатся, чтобы совершенствовать свою пользу для людей.

Самые известные ИИ-сервисы предоставляются широкой аудитории бесплатно. Однако разработчики все же получают с них прибыль, — только менее очевидными путями:

- использование данных для дообучения, упомянутое выше — с обезличиванием, и здесь информация несет ценность сама по себе;

- передача агрегированных данных третьим лицам для таргетирования рекламы (обычно так делают малоизвестные стартапы);

- подписка на премиум-услуги: базовый функционал доступен всем, но для более продвинутых функций оформляется платеж;

- лицензирование технологий: расширение API для интеграции нейросети в другие приложения;

- фандрайзинг, краудфандинг, финансирование от инвесторов и другие виды монетизации.

Важно помнить, что нейросети, обученные на открытых базах, не различают по умолчанию конфиденциальную и публичную информацию, — это задача только пользователей. При том, что крупные платформы вроде OpenAI или Claude обычно избегают практику передачи данных из-за репутационных рисков, безопасность сведений в первую очередь зависит от самих людей.

Как понять, безопасна ли нейросеть

Многие открытые ИИ-модели работают через облачные платформы — для масштабирования. Информация хранится на их серверах в центрах обработки данных (ЦОД). В этих случаях доступ к сведениям, которые пользователи отправляют нейросетям (запросы, файлы), получают не только разработчики, но и облачные провайдеры. Государственные органы или регуляторы по решению суда тоже могут войти в эту цепочку. Сами ЦОДы могут располагаться в разных странах и таким образом подчиняться разным юрисдикциям.

Обычно сервисы и сайты на базе ИИ, которые собирают данные о посетителях, запрашивают у них разрешение на обработку данных. Иногда нужно проставить галочку в чекбокс, — но в других случаях сервис может разместить предупреждение, что человек, пользуясь им, автоматически дает согласие на обработку информации.

Чтобы отличить добросовестный ИИ-сервис от потенциально небезопасного, нужно следовать нескольким правилам:

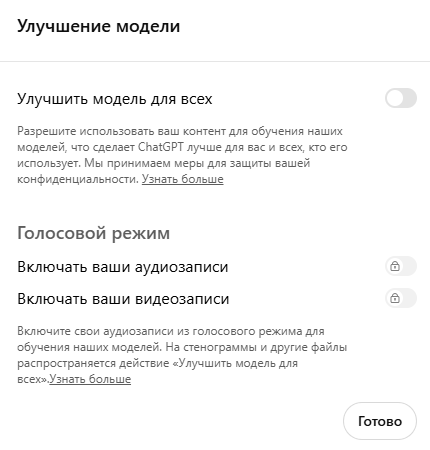

Изучить политику конфиденциальности — есть ли в ней пункт об использовании данных (в том числе для дообучения) и можно ли отменить эту опцию. Например, в ChatGPT можно отключить историю и запоминание чатов. В китайском DeepSeek и Copilot корпоративные подписки позволяют выключать сбор сведений. А в Gemini и некоторых других данные часто используются для улучшения модели.

Проверить, обезличивает ли ИИ-сервис данные. Относительно безопасно передавать информацию источникам, которые применяют этот метод защиты. Однако проверить, действительно ли это происходит и в какой форме, зачастую невозможно. С осторожностью стоит воспринимать малоизвестные аналоги популярных нейросетей, генераторы документов и резюме, программы для написания писем, открытые дашборды и сервисы для прогнозирования.

Выяснить, где расположены серверы и кому принадлежит нейросеть: США, ЕС, Китай? Уровни защиты могут различаться в зависимости от территорий. У небольших и недорогих облачных провайдеров обычно меньше ресурсов и внимания к соблюдению правил, и как следствие прозрачности. Такое бывает у отдельных поставщиков в некоторых странах Азии и Африки, где регуляторная среда менее жесткая, чем в других. О репутации поставщика может сказать наличие соответствующих международных сертификатов.

Проверить отзывы и инциденты — известны ли случаи утечек. Чаще всего они происходят по вине недобросовестных провайдеров или через незащищенные каналы. Однако даже проверенные ИИ-сервисы не застрахованы от целевых атак киберпреступников.

Основные риски для пользователей нейросетей

Как и любые прорывные технологии, нейросети, обрабатывающие миллионы запросов, становятся лакомой целью для злоумышленников. Международное аналитическое агентство в сфере финансов Bobsguide опубликовало данные глобального отчета Cybercrime Trends 2025 (SoSafe), согласно которому 87% организаций сообщили об угрозах, связанных с ИИ. А 91% специалистов по кибербезопасности прогнозируют значительный рост аналогичных угроз в ближайшие три года.

Фишинг, давно известный среди «обыкновенных» сервисов, касается и сферы ИИ. Мошенники создают поддельные инструменты, имитирующие популярные нейросети (условно, некий поддельный ChatGPT), эксплуатируют возможности генеративных ИИ для создания фейковых писем, изображений или даже видео. Их цель — заполучить персональную информацию пользователей для прямой кражи или шантажа, и в том числе в масштабах корпораций.

Чтобы не попасться на «удочку», необходимо проверять доменные имена, email и телефоны адресантов — и внимательно относиться к веб-ссылкам и запросам проверочных кодов.

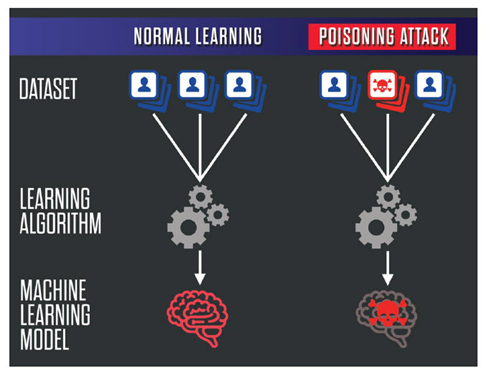

Существует вид атаки на машинное обучение — «отравление данных» (data poisoning). Это введение вредоносных данных в обучающий набор ИИ-модели, удаление части данных, ложные отсылки, искажение разметки классов (например, когда фотографии людей обозначаются как изображение других объектов). Оно влияет и на подрыв безопасности в распознавании лиц, фальсификации транзакций, подмену диагнозов и назначений в медицинских учреждениях.

Помимо традиционных методов (антивирус, брандмауэр, контроль сетей), чтобы предотвратить «отравление», нужно проводить аудит датасетов, мониторить аномалии и настраивать валидацию данных.

Недостоверность сведений — нежелательная, но возможная особенность самих нейросетей. При всей многогранности функционала искусственный интеллект, помимо «постороннего вторжения», иногда допускает естественные ошибки. Например, приводит несуществующую статистику или определяет неоднозначные сведения как достоверные.

В работе с ИИ всегда уместен принцип «доверяй, но проверяй»: ему можно задать прямой вопрос, откуда он взял данные, и точно ли он уверен в своей правоте. Проверенные модели готовы признать ошибку и выдать пояснение. Но полезнее всего — использовать экспертный человеческий надзор для проверки решений ИИ. Особенно важно следить за процессом, когда речь идет о подготовке важных отчетов, статей и документов.

В 2023 году Samsung столкнулся с утечкой данных по вине сотрудников, которые случайно загрузили внутренний исходный код в ChatGPT. С тех пор корпорация запретила использование генеративных ИИ на всех устройствах, принадлежащих компании, а также ввод в ChatGPT информации, касающейся Samsung.

В том же году сама OpenAI сообщила об утечке персональных данных пользователей ChatGPT. Из-за ошибки в работе библиотеки с открытым исходным кодом некоторые участники могли увидеть чужие сообщения, ФИО, контакты и платежную информацию платных подписчиков. Чат-бот отключили на несколько часов, проблему удалось устранить, но сам факт насторожил пользователей по всему миру.

Безопасная работа с ИИ в корпоративной сфере

Если в повседневной жизни риски в общении с нейросетями можно снизить при должной бдительности, — а мы уже изучили, как и почему персональные данные нужно беречь, — то в отношении бизнеса все не так просто.

Здесь, помимо личных данных и доступов, в оборот входят коммерческие тайны, патентные разработки, планы, стратегии, технические и организационные детали. Вредоносное вмешательство и утечки могут стоить компаниям невероятных денежных и репутационных потерь. Публичные облачные нейросети требуют особых мер защиты даже при интеграции через API, и оправданность таких рисков сомнительна.

Однако совсем оставить бизнес-сектор без поддержки новейших моделей ИИ было бы крайне нецелесообразно. На помощь приходят корпоративные облачные нейросети. Помимо классической пользы в упрощении самых разнообразных процессов, такие разработки позволяют в значительно большей степени обезопасить компанию от потенциальных рисков, связанных с ИИ.

Такие сервисы обладают повышенной степенью защиты и расширенными конфигурациями:

- В корпоративных решениях гораздо больше контроля над обработкой данных, а в открытых облачных они передаются стороннему сервису на его условиях.

- В корпоративном формате можно ограничить доступ, определить политику хранения и удаления информации, настроить сертификацию для работы с конфиденциальными данными, чего нет в общедоступном.

- Открытые алгоритмы более уязвимы для атак, связанных с компрометацией поставщика, в то время как корпоративные обладают большей защищенностью.

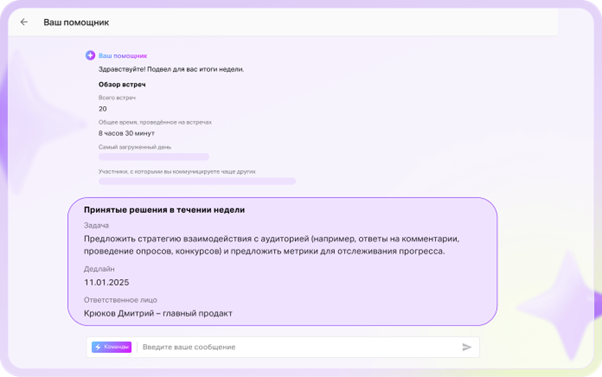

Облачные корпоративные нейросети могут быть основой продукта (как российская NTechLab, которая обеспечивает распознавание лиц и объектов и работает с городской сетью камер Москвы), а могут служить «дополнительным инструментом», улучшая его. Например, в Directum RX, который используется для управления данными, встроенный ИИ помогает генерировать документы, письма, анализировать контент и выставлять задачи, выделять трудозатратные процессы и загруженность пользователей. А в экосистеме «МТС Линк», куда входят сервисы для бизнес-коммуникаций, обучения и совместной работы, ИИ помогает генерировать резюме и расшифровки созвонов и тредов в мессенджере, создает видеохайлайты — короткие видео с главными моментами онлайн-встреч. Также в платформу встроен виртуальный ассистент — ИИ-помощник.

Альтернативой формату корпоративных облачных нейросетей может стать развертывание self-hosted-моделей — топовое решение по уровню безопасности. Оно подразумевает разработку собственных ИИ-систем полностью на оборудовании компании. Все серверы, функционал и массивы данных создаются внутри предприятия или локально на устройствах, без передачи данных сторонним сервисам. Такой способ очень надежен (хотя хакеры могут проявлять интерес даже к таким системам), однако требует огромных затрат на создание и поддержание всей инфраструктуры.

В широком смысле сервисы на базе ИИ для бизнеса помогают значительно улучшить все рабочие процессы и рутинные операции. Они могут затрагивать все сферы, включая общение с потребителями, проведение онлайн-встреч для сотен и тысяч сотрудников, маркетинговые решения и многие другие. К примеру, MTS AI одновременно выпускает различные проекты в сфере видеоаналитики, синтеза и распознавания речи и умного прогнозирования.

Обложка: Kandinsky 3.1, rudalle.ru