Компания Apple начала сканировать фотографии пользователей на iCloud. Сотрудники отметили, что они ищут файлы, на которых могут быть признаки жестокого обращения с детьми, а также сексуальной эксплуатации несовершеннолетних. Об этом на форуме CES 2020 заявила старший директор компании по вопросам конфиденциальности Джейн Хорват.

Специалистка отметила, что этим занимаются не ее коллеги, а специальная программа. «Apple использует технологию сопоставления изображений. Подобно спам-фильтрам в электронной почте наши системы используют электронные подписи для поиска подозрительных изображений. Учетные записи, которые используются для хранения таких фотографий, нарушают условия обслуживания и подлежат незамедлительному удалению», — добавила она.

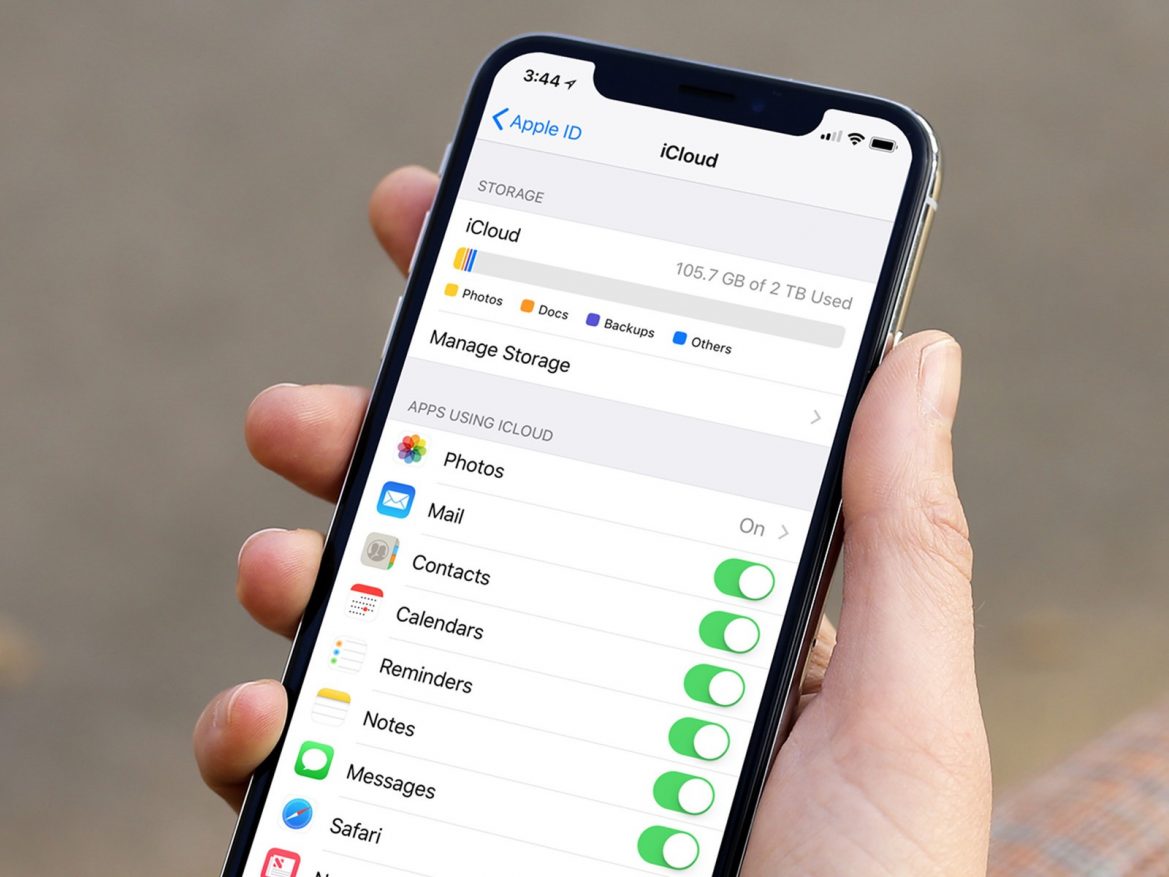

При этом в компании отметили, что эта процедура началась лишь в 2019 году, об этом Apple рассказала в обновленном положении о конфиденциальности. В то же время компания продолжает использовать ключи сквозного шифрования для защиты информации пользователей.

Как предполагает автор издания The Guardian, алгоритм Apple сканирует детали изображений и автоматически сравнивает их с контентом, который размещается на порносайтах. Тот же алгоритм может замечать «подозрительные подписи». Проверяет ли данные после этого живой сотрудник Apple, неизвестно.