Следуя традиции, Google провела свою ежегодную весеннюю презентацию I/O. Однако, вопреки ожиданиям, компания не представила новую версию Android 15 и новинки линейки смартфонов Pixel. Двухчасовую презентацию полностью посвятили искусственному интеллекту.

Улучшенная Gemini 1.5 Pro

На мероприятии Google I/O представили Gemini 1.5 Pro — улучшенную версию искусственного интеллекта от Google. Эта модель отличается рядом значительных улучшений по сравнению с предыдущими моделями.

Одна из ключевых особенностей Gemini 1.5 Pro — расширенное контекстное окно на 2 млн токенов. Это означает, что ИИ может обрабатывать и анализировать гораздо большие объемы текста одновременно, что в 16 раз больше по сравнению с возможностями GPT-4o. Это позволит, например, загружать и перерабатывать такие крупные тексты, как «Война и мир», предоставляя сжатые пересказы.

Дополнительно, Google расширила для нейросети поддержку языков — теперь их 35, включая русский.

Gemini 1.5 Pro также интегрируют в различные продукты Google, включая:

- Google Фото — ИИ поможет искать текст на фотографиях и создавать тематические коллажи.

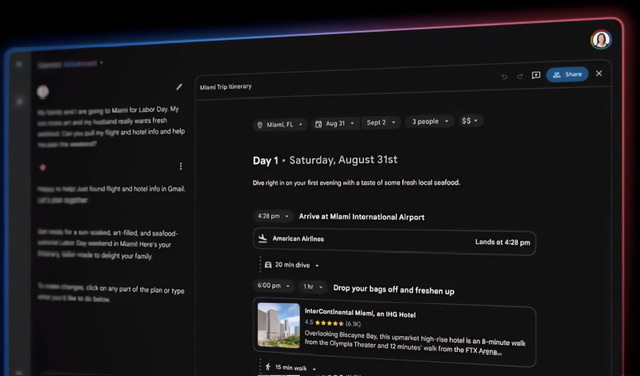

- Gmail — ИИ поможет пользователям составлять краткие пересказы полученных писем, автоматически собирая важные задачи.

- Google Поиск — там появится раздел с ИИ для быстрого предоставления информации по запросам пользователей.

- Google Meet — ИИ будет автоматически составлять пересказы видеозвонков.

Внедрение этих инноваций начнётся в 2024 году и первоначально будет доступно пользователям в США, с последующим расширением на другие рынки. Это обновление делает Gemini 1.5 Pro одним из самых передовых ИИ-инструментов, доступных на рынке.

Возможности Gemini в смартфоне Pixel

После того как OpenAI представила модель GPT-4o, Google показала возможности своей нейросети Gemini в смартфоне Pixel, на видео, предваряющем конференцию Google I/O. На кадрах видно, как Gemini общается с пользователем, делая логические выводы мгновенно и без ошибок.

Согласно отчету Tom’s Guide, в демо Gemini комментирует подготовку сцены для мероприятия, узнавая в ней место для будущей конференции Google I/O и коротко описывая это ежегодное событие. Это напоминает недавнюю презентацию ChatGPT, где пользователей впечатлила естественность диалога.

Однако Google не раз критиковали за излишне оптимистичные заявления о своих инновациях в сфере ИИ. В прошлом некоторые анонсированные функции в реальности оказывались менее впечатляющими, чем обещано.

Самый мощный ИИ-генератор изображений Imagen 3

На конференции Google представила новую версию генеративной нейросети Imagen третьего поколения. Согласно заявлению руководителя исследовательского подразделения Google DeepMind, Демиса Хассабиса, Imagen 3 — самый продвинутый генератор изображений на данный момент. Нейросеть лучше интерпретирует текстовые запросы и создает изображения с большей креативностью и детализацией. Разработчики позаботились о том, чтобы Imagen совершала меньше ошибок и производила меньше нежелательных артефактов.

Чтобы предотвратить создание дипфейков, Google использовала технологию SynthID. Она добавляет невидимые криптографические водяные знаки в медиафайлы. По задумке, это исключит возможность использование изображений для распространения поддельного контента.

Для частных пользователей доступна подписка на Imagen 3 с помощью сервиса Google ImageFX. Разработчики и корпоративные клиенты получат доступ с помощью платформы машинного обучения Vertex AI.

Представители Google не сообщили, какие данные использовали разработчики для обучения обновленного алгоритма.

ИИ-ассистент Gemini Live с естественной речью и компьютерным зрением

Также на мероприятии Google I/O 2024 анонсировали новые функции чат-бота на основе ИИ Gemini — Gemini Live. Благодаря ним бот превращается в продвинутого ИИ-ассистента.

Одна из ключевых особенностей Gemini Live в том, что он уточняет детали запросов. Чат-бот будет адаптироваться и обучаться в реальном времени. Кроме того, Gemini Live может анализировать окружение пользователя, используя фото и видео с камеры смартфона.

Эта функция сочетает в себе технологии компьютерного зрения Google Lens и возможности виртуального помощника Google Assistant.

Несмотря на кажущуюся простоту обновления, Google подчеркивает, что оно «включает продвинутые методы генеративного ИИ», обеспечивая «естественный и эмоционально насыщенный диалог».

Gemini Live разработали в рамках проекта DeepMind Project Astra. Он предназначен для работы с текстом, аудио и изображениями в реальном времени. Цель проекта — создать универсального агента для повседневного использования.

К концу года Gemini Live сможет отвечать на вопросы о предметах в поле зрения камеры смартфона, например, о местоположении пользователя или названии сломанной детали велосипеда. Пользователи смогут направлять камеру на части компьютерного кода, и ИИ объяснит их функции.

Live также может выступать в роли виртуального наставника, помогая пользователям подготовиться к выступлениям или мероприятиям, разработать идеи и многое другое. Он может подсказать, какие компетенции стоит выделить на будущем собеседовании или стажировке, или дать рекомендации по технике публичных выступлений.

Мощнейший серверный ИИ-процессор Trillium

На конференции Google I/O компания также анонсировала запуск шестого поколения тензорного процессора Trillium. Этот чип создали для работы в центрах обработки данных, специализирующихся на задачах искусственного интеллекта. Согласно заявлению представителей Google, его производительность в пять раз выше предшественника. Особенно разница заметна в задачах, связанных с обработкой текстов и медиа с помощью крупных языковых моделей ИИ.

Компания также сообщает, что новый чип на 67% более энергоэффективен. По информации TechCrunch, значительный прирост производительности был достигнут за счет увеличения числа матричных умножителей и повышения тактовой частоты, а также удвоения пропускной способности памяти.

Технические детали Trillium не раскрыты подробно, но ожидается, что новый процессор станет доступен для клиентов облачных сервисов Google к концу 2024 года.

Процессоры, разрабатываемые Alphabet, родительской компанией Google, — ключевые элементы в инфраструктуре данных, ориентированной на ИИ.

ИИ-модель Gemini Nano в Google Chrome для ПК

Google объявила о внедрении ИИ-модели Gemini Nano в браузер Chrome для ПК, начиная с версии Chrome 126. Эту продвинутую языковую модель интегрируют в фирменный веб-обозреватель компании.

Как отмечает Google, это новшество даст возможность сторонним разработчикам использовать мощь большой языковой модели непосредственно на устройствах пользователей для создания собственных ИИ-функций.

Компания также планирует использовать Gemini Nano для реализации различных функций, включая функцию Help Me Write в Gmail в рамках платформы Workspace Lab, которая поможет пользователям генерировать полноценные электронные письма на основе кратких указаний.

Google также сообщила, что благодаря поддержке WebGPU и WASM в Chrome, ИИ-модели смогут работать эффективно на компьютерах с различной аппаратной конфигурацией. Кроме того, компания ведет переговоры с разработчиками других браузеров о возможности интеграции разработанных в Google ИИ-функций в их продукты.

Project Astra — ИИ-ассистент, который все видит и понимает

На ежегодной конференции для разработчиков Google I/O предварительно представили проект, известный внутри компании как универсальный ИИ-помощник под кодовым названием Project Astra. Его особенность в том, что он способен работать в режиме онлайн, «видеть» окружение, распознавать объекты и помогать в выполнении разнообразных задач.

Google также выпустила короткое видео, демонстрирующее возможности Project Astra.

В нем сотрудница из лондонского офиса компании активирует ИИ-помощника и просит его отметить объекты, издающие звуки. Когда камера смартфона фиксирует колонку на столе, ИИ сообщает об этом. Затем она показывает на цветные мелки в стакане, и ИИ комментирует, что они могут быть использованы для создания «красочных творений». Когда камеру наводят на экран с кодом, ИИ моментально объясняет его назначение. Помощник также определяет местонахождение офиса по виду из окна и выполняет другие задачи, все это — в режиме реального времени.

На презентации заявили, что Project Astra «превосходит предыдущие разработки» «является примером того, как должен функционировать ИИ-помощник в реальном времени». Он основан на последней большой языковой модели Gemini 1.5 Pro.

Пока что проект находится на ранней стадии разработки, и точные сроки его запуска пока не объявили.

Google Lens научили работать с видео и аудио

Google обновила свой инструмент для визуального поиска, Google Lens, добавив возможность искать информацию через видео и аудио. Теперь пользователи могут не только искать по картинкам, но и задавать вопросы, используя видео и звук.

Это улучшение поможет в таких ситуациях, как поломка автомобиля или если нужно больше узнать о чем-то, что видно перед вами. Просто направьте камеру на интересующий объект и спросите о нём. Это делает использование технологии проще и удобнее. Google продолжает внедрять искусственный интеллект в свои продукты, делая их более понятными для пользователей.

Circle to Search научился решать уравнения

В начале года Google представила новую функцию для Android-смартфонов под названием Circle to Search. Используя ее, пользователь может обвести интересующий фрагмент на экране телефона и моментально получить информацию о содержимом одним касанием.

Теперь разработчики улучшили этот инструмент, чтобы помочь учащимся, которые изучают математику или физику.

Используя функцию на Android-смартфоне или планшете, студенты смогут легко решать уравнения: достаточно обвести задачу, и на экране появится всплывающее окно с подсказками по решению. Google заявила, что хотя новая функция и предоставит необходимую поддержку, она не будет выполнять всю работу за пользователя, чтобы способствовать самостоятельному обучению учеников.

Позже в этом году функция Circle to Search сможет решать более сложные математические задачи, включая работу с формулами, диаграммами и графиками. Разработка новых возможностей основана на использовании ИИ-модели LearnLM.

Gemma 2 — открытая ИИ-модель с 27 млрд параметров

В Google объявили о предстоящем выпуске новой модели искусственного интеллекта с 27 миллиардами параметров — Gemma 2. Она будет основана на открытом исходном коде.

Запланированный релиз состоится в июне текущего года.

Нейросеть Gemma 2 обещает стать лидером в отрасли по производительности за счет компактных размеров и специальной оптимизации для работы на графических процессорах следующего поколения от Nvidia или на одном Google Cloud TPU в рамках сервиса Vertex AI. Однако пока Google не предоставила детальной информации о технических аспектах алгоритма Gemma 2.

Ожидается, что реальное качество и возможности модели станут ясны после ее релиза и тестирования разработчиками. Согласно заявлению Google, производительность Gemma 2 вдвое превышает аналогичные показатели более крупных моделей.

Читать далее:

Оказалось, в прошлом Марс был больше похож на Землю, чем все думали

Сибирские «врата в подземный мир» растут: что происходит в Батагайке