Мы уже писали про то, что ученые научили нейросети самостоятельно усложнять механизмы защиты передаваемой друг между другом информации. Единственная проблема была в том, что исследователи, добившиеся этого результата, также заявили, что пока не могут объяснить механизм приведший к усложнению, то есть они сами не знают, что точно произошло в их алгоритмах.

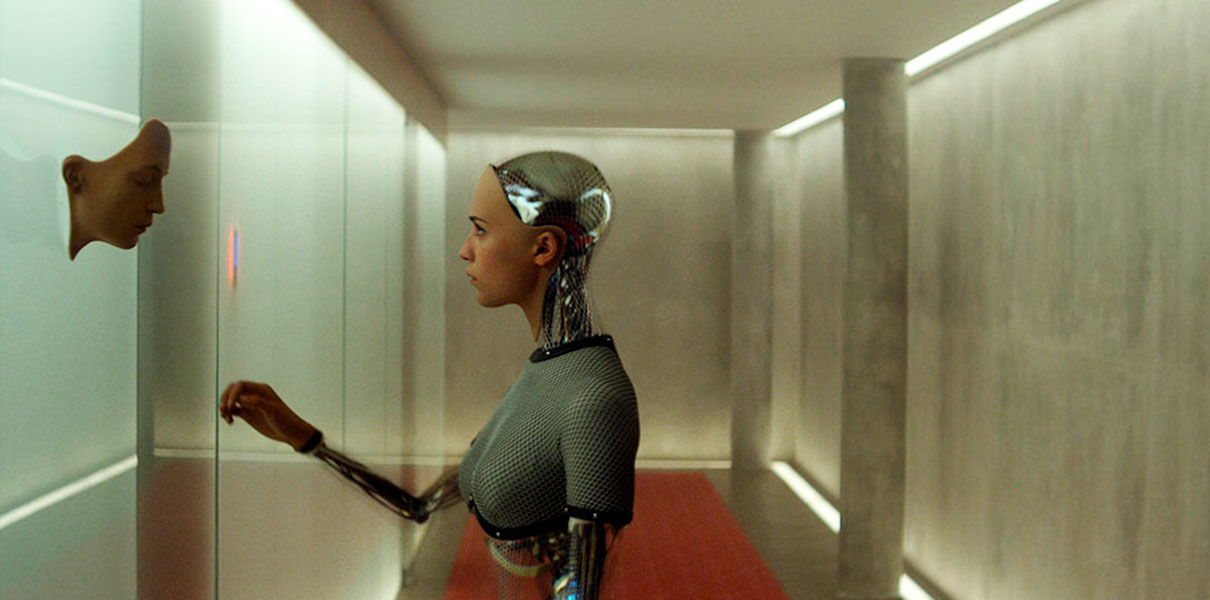

Сегодня к ним на помощь пришли коллеги из Массачусетского технологического института. Они разработали механизм, с помощью которого нейросети могут рассказать, почему они приняли именно такое решение. В более широком смысле это значит, что алгоритмам можно будет доверять, так как они будут принимать решения понятным для человека образом. Сегодня сложные программы распознают голоса, идентифицируют людей, часть из них делает сложные прогнозы на бирже, но доверие к их результатам снижается за счет отсутствия прозрачности.

Врачам впервые удалось полностью вылечить пациента от ВИЧ

Кейсы

Команда из МТИ обучала нейросеть на текстах и пятизвездочных рейтингах с сайта, который собирает отзывы о пиве. Алгоритм анализировал текст на связность, изучал рейтинги. В результате стал действовать практически так же, как человек. Его оценки на основании текстов совпадали с человеческими, что вызывало доверие к решениям. Оценки вкуса и аромата он угадал в 96% случаев и в каждом из них можно было получить объяснение, на основе чего такая оценка получена.

В то время, когда ученые и известные предприниматели все чаще заявляют о том, что ИИ представляет угрозу, не очень комфортно иметь под боком черный ящик, о котором известны только входные и выходные данные. Перспективной задачей ученых МТИ является обретение контроля над внутренностями ИИ. Работа с нейросетями как и любой лабораторный эксперимент, должна стать полностью прозрачной и контролируемой.

Технология российского стартапа изменит мировой рынок обуви

Кейсы